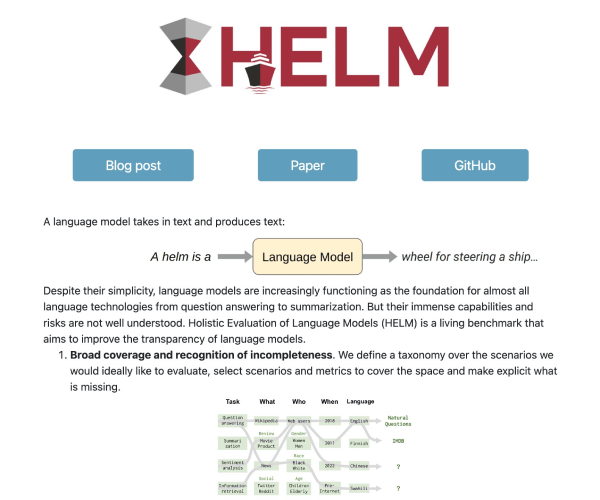

「HELM」是什么

HELM是一款用于全面评估语言模型的工具。它为开发者和研究人员提供了多维度的评估方式,能够深入了解语言模型的性能,助力其更好地优化与发展。凭借独特的评估体系,在AI领域备受关注。

功能解析

- 多维度评估:从多个不同角度对语言模型展开评估,涵盖准确性、泛化能力等多个关键指标,让评估结果更全面、精准。

- 模型对比:支持将不同的语言模型放在一起进行对比评估,方便用户清晰地了解各模型间的差异,从而做出更合适的选择。

产品特色

- 全面性:评估内容十分全面,不仅仅局限于基础性能,还深入到模型在复杂场景下的表现,这是很多同类工具难以企及的。

- 专业性:由专业团队打造,运用先进的技术和算法,确保评估结果的科学性和权威性。与市场上一些普通评估工具相比,更值得信赖。

应用场景

- AI研究场景:研究人员在开发新的语言模型时,借助HELM进行性能评估,及时发现模型的问题所在,对模型进行针对性的优化。比如在某知名研究机构开发新模型过程中,通过HELM评估发现模型在处理长文本时准确性较低,进而优化算法,提升了模型性能。

- 企业应用场景:企业在选择合适的语言模型应用于业务时,利用HELM对比不同模型,选择最契合业务需求的模型。例如某电商企业在挑选客服语言模型时,用HELM评估后,选择了能快速准确回答用户问题的模型,提升了客户服务质量。

使用指南

首先,进入HELM的官方平台。接着,按照平台指引上传需要评估的语言模型相关数据。然后,选择想要进行的评估维度和对比模型。最后,等待评估结果生成即可。在操作过程中,用户可能会遇到数据上传格式不支持的问题,此时只需按照平台提示的正确格式进行调整即可。