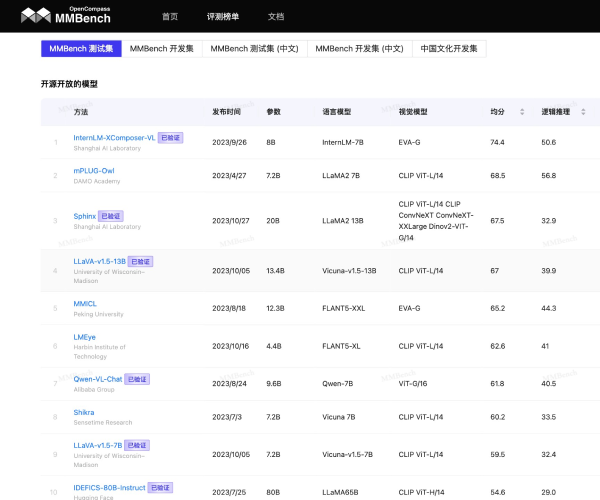

「MMBench」是什么

MMBench是一个用于评估大模型性能的平台,旨在为众多模型提供全面、科学的评测服务。它接受来自开源语言模型、公共语言模型应用程序编程接口(API)以及私有语言模型的评测申请,众多公司和组织开发的模型都在此进行性能展示,能帮助开发者更好地了解模型的优势与不足。

功能解析

- 全面评估:MMBench可以对多种类型的模型进行综合评测,从不同维度考量模型性能,比如语言理解、视觉识别等方面,给出较为全面的评估结果,让使用者对模型能力有清晰认知。

- 数据对比:通过对不同模型在相同任务上的表现进行数据对比,能直观呈现各模型之间的差异,帮助开发者根据自身需求选择最合适的模型 。

产品特色

- 广泛的模型覆盖:无论是已经发布的公开模型,还是暂时未公开的私有模型,都能在MMBench上进行评测。这使得该平台涵盖了众多模型,评测结果具有广泛的参考价值。

- 专业的评估体系:拥有一套科学、专业的评估体系,从多个角度对模型进行考核,确保评测结果的准确性和权威性,为模型的优化和应用提供可靠依据。

应用场景

- 模型研发场景:开发者在研发新模型或优化现有模型时,借助MMBench的评测功能,了解模型在不同方面的性能表现,针对不足进行改进,提升模型质量。例如某公司在研发新的多模态模型时,通过MMBench的评测发现模型在图像理解方面存在问题,从而进行针对性优化。

- 模型选择场景:企业或研究机构在选择合适的模型应用于具体项目时,MMBench提供的评测数据能帮助他们对比不同模型的优势和劣势,做出更明智的选择。比如一家广告公司在选择用于广告创意生成的模型时,参考MMBench的数据,挑选出语言生成能力强的模型。

技术原理解析

MMBench通过设定一系列具有代表性的任务和指标,运用专业的算法和工具,对模型在处理这些任务时的表现进行量化分析。例如在语言任务中,通过对模型生成文本的准确性、连贯性等指标进行评估;在视觉任务中,对模型识别图像内容、进行图像分类等能力进行考核,最终综合各项数据得出全面的评测结果。

使用指南

若想在MMBench上进行模型评测,首先要确定模型类型是否符合平台接受范围。如果是开源模型或有公开API的模型,按照平台指定的接口规范上传相关数据和模型信息;若是私有模型,在评测完成后若希望将结果展示在排行榜上,需发送邮件至opencompass@pjlab.org.cn。之后等待平台依据其专业流程完成评测,并给出详细的评估报告。