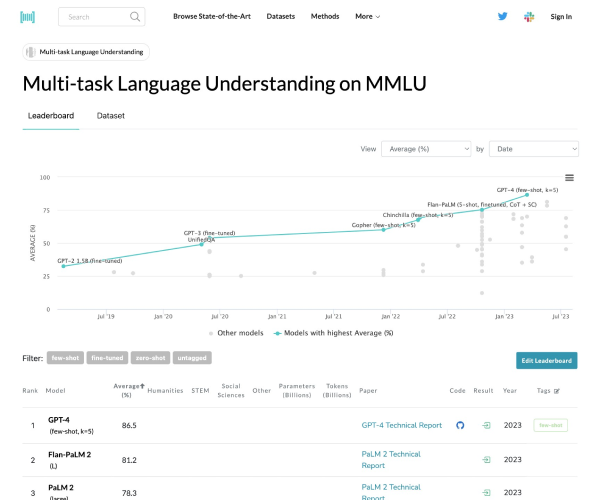

「MMLU」是什么

MMLU是一款专注于多任务语言理解评测的工具,在大模型评估领域发挥着重要作用,为衡量模型语言理解能力提供了有效方式。

功能解析

- 多领域评测:可对大模型在多个领域的语言理解能力进行全面评测,涵盖不同知识范畴。

- 精准评估:借助特定算法和数据集,精准衡量大模型的语言理解水平。

产品特色

- 丰富数据集:拥有大量专业数据集,确保评估的全面性与准确性。

- 专业评估体系:具备一套科学严谨的评估体系,能给出可靠评估结果。

应用场景

- 大模型研发场景:研发人员在开发大模型过程中,利用MMLU评估模型语言理解能力,以便针对性优化改进。

- 模型对比场景:当需要对比不同大模型的语言理解能力时,MMLU可提供客观公正的评估数据。

使用指南

目前未获取到详细使用步骤相关信息。