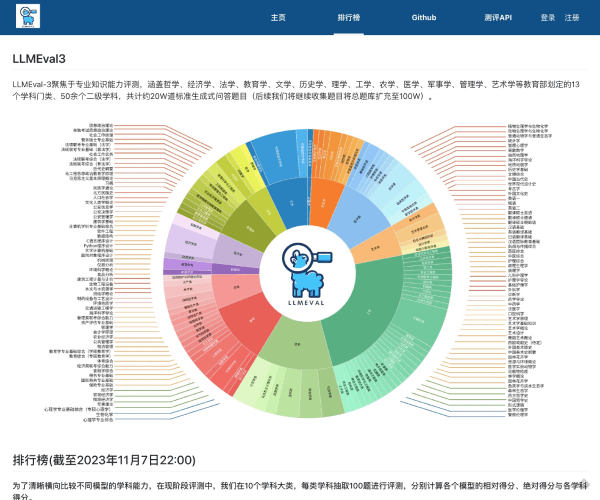

「LLMEval3」是什么

LLMEval3是一款在AI大模型评测领域有着重要地位的工具。它能为用户提供关于AI大模型的多方面评测,助力用户深入了解模型性能,为模型的应用和优化提供有力支持 。

功能解析

- 精准评测:可以从多个维度对AI大模型进行精准的评估,包括模型的准确性、稳定性等,让用户清晰掌握模型表现。

- 高效评测:能够快速给出评测结果,节省用户大量时间,提高评测效率。

产品特色

LLMEval3在市场上的独特卖点在于其专业性与高效性。和其他同类产品相比,它有着更精准的评测体系,能给用户带来更具价值的评测报告,帮助用户在模型选择和优化上做出更明智的决策。

应用场景

- 会议评测场景:在会议场景中,用户常面临需要快速评估大模型是否能满足会议需求的问题,比如能否准确理解会议内容并进行总结。LLMEval3能快速对相关模型进行评测,为会议选择合适的模型提供依据。

使用指南

首先进入LLMEval3的操作界面,然后选择需要评测的AI大模型,设置好评测参数,点击开始评测按钮,等待评测结果生成即可。