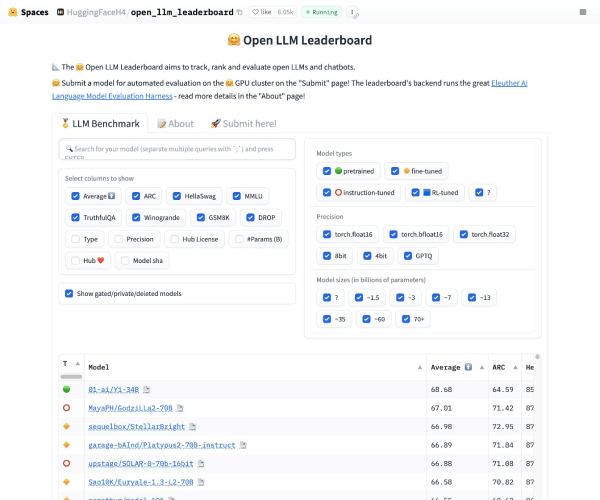

Hugging Face 推出了一个名为 Open LLM Leaderboard 的开放式平台,这是一个致力于大型语言模型(LLM)和数据集的社区。该排行榜利用 Eleuther AI 语言模型评估框架,为用户提供了一个透明和标准化的方式来衡量不同模型的性能。

背景与必要性

随着开源社区发布越来越多的大型语言模型和聊天机器人,市场中出现了大量关于这些模型性能的宣称。这些宣传往往夸大其词,使得辨别真实进展和最前沿模型变得困难。为了解决这一问题,Hugging Face 引入了 Open LLM Leaderboard,旨在通过一致和全面的评估框架,为开发者和研究人员提供一个清晰的性能比较基准。

评估框架概览

Open LLM Leaderboard 使用以下四个关键基准测试对模型进行综合评估:

-

AI2 推理挑战(25-shot):这项测试包含了一系列基于小学科学的问题,用以评估模型在推理能力上的表现。

-

HellaSwag:该任务旨在测试机器的常识推理能力。尽管人类可以轻松完成(成功率约95%),但对于现有最先进的模型而言,它仍然是一个巨大的挑战。

-

MMLU:该基准测试用于测量文本模型在多任务设置中的准确性,涵盖从基础数学到美国历史、计算机科学、法律等多个领域的57个任务。

-

TruthfulQA:这是一个0-shot评估任务,旨在量化模型在复制网上常见虚假信息时的倾向。

为了更清铯的评价标准

通过这四个基准测试,Hugging Face 旨在为用户提供一个关于最先进模型在不同语言任务上表现的客观视角。这不仅有助于推进语言模型技术的发展,也为希望比较和选择适合特定应用场景模型的用户提供了重要的资源。

Open LLM Leaderboard 的推出,反映了 Hugging Face 对于推动语言模型技术进步的承诺,同时也体现了其提供开放、透明和协作环境的愿景。对于追求高阶语言处理能力的研究人员和开发者来说,这是一个不容错过的资源平台。

结语

Open LLM Leaderboard 为大型语言模型的评估和比较提供了一个统一的标准化平台。随着社区的不断发展和模型性能的不断提升,这样的评估框架将越来越成为衡量技术进步和指导未来研究方向的关键工具。