2025年堪称中文大模型的变革之年,DeepSeek的问世意义非凡,打破了英伟达“算力决定一切”的固有观念,也冲击了美国在大模型领域的长期主导地位,还引发了全球大模型领域的价格战,让更多人得以接触大模型。从抖音、快手等平台的反馈来看,它将“人工智能”这一概念带到大众身边。

不过,DeepSeek服务器存在问题,发出请求后常出现“服务器繁忙,请稍后再试”的提示,这让用户迫切希望在本地部署推理模型。但通常运行大模型的设备成本较高,对于普通消费者并不友好。而一位DIY玩家决定挑战用400元打造一套能运行DeepSeek模型的入门级本地大模型主机。

在主机硬件选择上,CPU选用PDD上售价22元的Intel®Core™i3-4170,其为二核四线程,3.7GHz主频,有3MB智能缓存,采用22nm制程工艺的Haswell架构,关键是具备HD4400核显。主板则购入PDD上79元的铭瑄MS-H81MTurbo,虽配置有限,但性价比高。两者组成的板U套装仅需100左右。

显卡方面,闲鱼上流出的P106-090和P106-100矿卡是选择对象,P106-090有3GB显存,P106-100有6GB显存,为运行更高效的本地大模型,最终选择售价130元的技嘉P106-100。此外,配上两根杂牌DDR3内存组成双通道,用300W长城电源供电,一块120GBSATA SSD做系统盘,加上剩余的大水牛硅脂和20元的电脑城小机箱,400元装机完成。

装机完成后进行性能测试,Intel® Core™i3-4170性能有限,解锁功耗后相当于移动端酷睿六代、七代处理器水平。实测环节,其在CPU-Z和CINEBENCH测试中有相应跑分,日常办公、轻度娱乐尚可。技嘉P106-100在测评中,FireStrike测试Extreme模式下图形分数为6490分,TimeSpy基本测试中图形分数为4428分,性能与GTX1060相近,能和移动端RTX3050媲美。存储方面,40元的杂牌128GB SATASSD硬盘顺序读写和随机4K读写速度满足系统启动盘要求。双通道DDR3内存经测试,各项速度指标也适合该电脑。

在预算几百块打造可用的本地DeepSeek主机中,体验是关键。真正的DeepSeek-R1原始版本参数多、推理精度高,但计算资源和显存要求大,消费级显卡无法承受,官方推荐用专业显卡或电脑集群运行。消费级显卡只能用“蒸馏模型”,通过知识蒸馏让精简模型学习大模型行为。

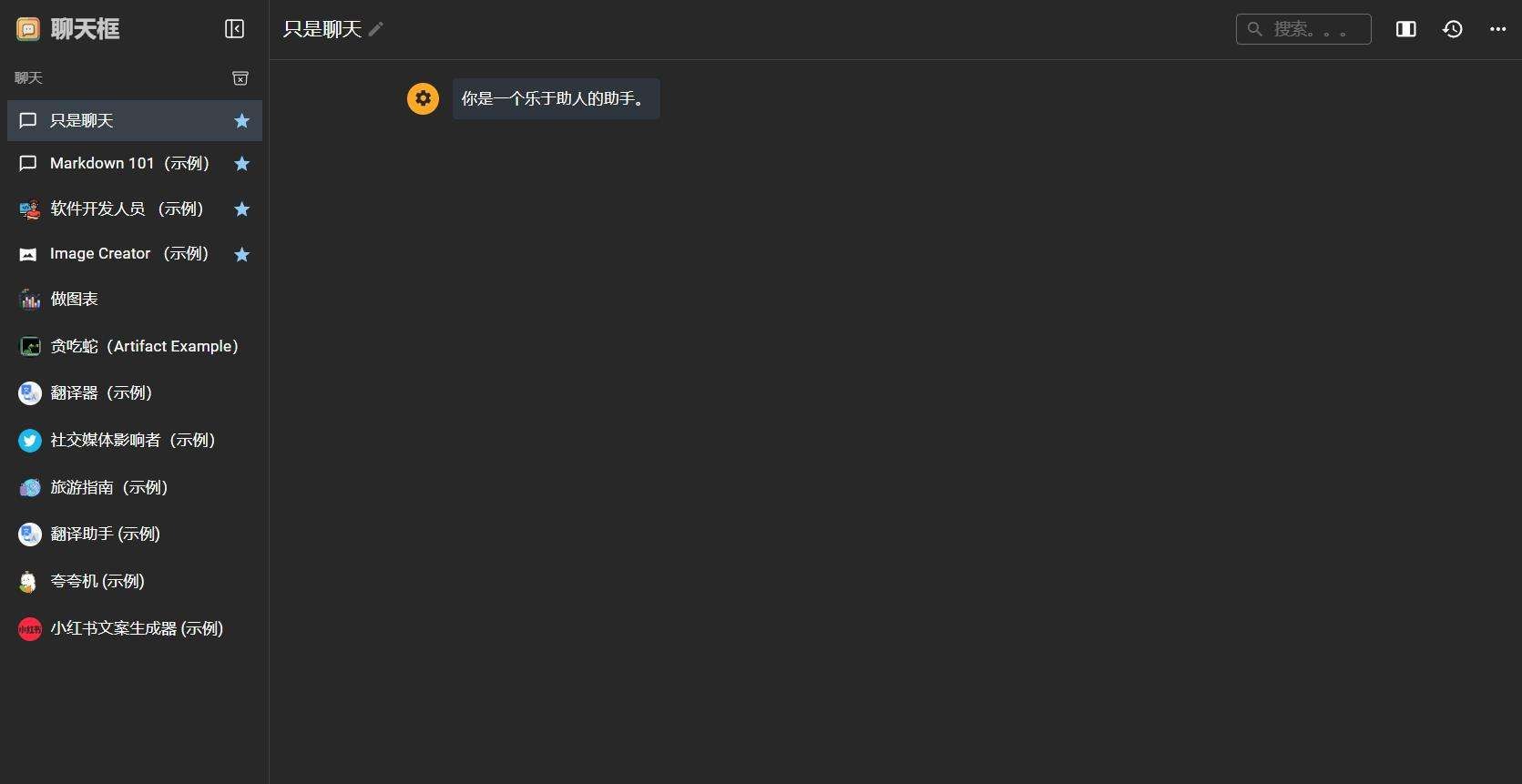

根据报告,DeepSeek-R1-Distil-Qwen-7B是符合需求的蒸馏模型中表现出色的,故选择部署该模型。目前在PC本地部署DeepSeek常见方法是OLLaMA+ChatboxAI组合。Ollama是流行的本地大模型服务端工具,在官网搜索DeepSeek-r1下载蒸馏模型后搭配客户端启动,一般在本地11434端口开启服务,但需额外前端客户端获得更好体验。ChatboxAI就是常见前端产品,它将设置和功能图形化,支持众多模型和接口,可接入本地Ollama服务。

另一种部署方法是Koblodcpp,它是整合Koblod.AI界面的llamacpp启动程序,能运行外网流行的GGUF格式本地大模型,还可整合语音和绘图大模型。在HF-Mirror下载模型后用其启动,可加载角色卡实现与不同角色对话。还能借助其端口部署SillyTarven,完善角色扮演体验,甚至让DeepSeek实现一些云端大模型无法做到的事。

实测中,用常规问题与本地部署的DeepSeek交互,能看到推理过程,应付初高中语数英问题体验不错,文学创作能力也可以。但在复杂数学、逻辑难题上表现一般,部分逻辑推理题无法给出答案。由于未联网,知识库截至2023年,时效性问题无法作答。在限制回复长度为1024代币时,思考一道高中数学题约127s,与原版DeepSeek速度差别不大,但因思考时间长,不太适合聊天,建议聊天用Casuallm大模型。

这套400元不到的主机有优点也有缺点。优点是成本低且能运行本地大模型;缺点是二手零部件质量无保障,矿卡驱动易掉,白屏问题频发。虽性能不错,能部署本地AI绘图等,可作为公司局域网AI终端,也能在低画质下运行3A大作和网游,但矿卡和二手电源问题较多。市面上的本地DeepSeek部署多为蒸馏后的通义千问模型,与全参数版本在复杂逻辑思考能力上差距明显。若追求不卡的全参数DeepSeek体验,使用APi接口或许更合理。