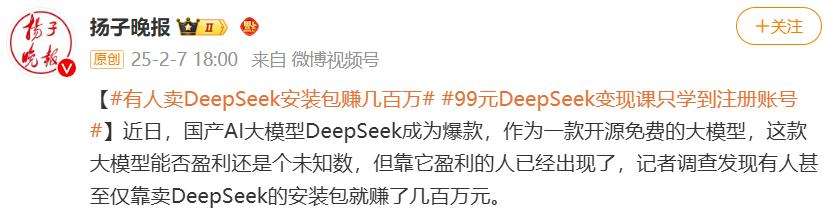

近期,免费开源的DeepSeek模型引发了一股本地部署热潮,这一现象甚至催生出倒卖模型资源的市场。在淘宝和拼多多等平台,本可免费获取的DeepSeek安装包、提示词包与教程等资源被明码标价出售,就连清华大学发布的《DeepSeek从入门到精通》也未能幸免。

DeepSeek-R1虽不是最强大的推理模型,但热度极高。使用官网或其他托管商服务时,常面临服务器繁忙等问题,而本地部署能有效解决这些困境。本地部署即在本地设备安装AI模型,不依赖云端APi或在线服务,常见方式包括轻量级本地推理、服务器/工作站部署、私有云/内网服务器部署以及边缘设备部署等。

本地部署具有诸多好处。在数据隐私与安全性方面,无需上传关键数据到云端,可防止数据泄露,符合数据合规要求;低延迟与高实时性能方面,计算在本地进行,推理速度取决于设备性能,适合实时性关键应用;更低的长期成本方面,无需API订阅费用,还可通过部署轻量化模型控制硬件成本;可以离线使用,适用于多种场景,保证关键业务不中断;可定制与可控性强,能微调、优化模型,不受第三方政策变更影响。

然而,本地部署也存在缺点。硬件成本高,个人设备运行高参数量模型困难;难以处理大规模任务,需服务器规模硬件;有一定部署门槛,本地微调难度更大;需要一定维护成本,要解决模型和工具升级带来的环境配置问题。

本地部署DeepSeek-R1有多种方法,这里介绍两种。一是基于OLLaMA部署,Ollama是常用的本地部署框架,轻量且扩展性好。先下载安装Ollama,再根据硬件配置选择DeepSeek-R1版本,通过命令运行模型,下载完成后可配置OpenWebUI或Chatbox等前端工具进行使用。

二是使用LM StUdio零代码部署,先从官网下载程序,安装后在My Models选项设置模型文件夹,然后从HuggingFace下载.gguf格式的模型文件放入该文件夹,即可在LM Studio中加载模型使用。

以上只是基础层面的本地部署教程,若想将DeepSeek-R1更好地整合进本地工作流程,还需进一步配置。随着硬件和相关技术发展,未来本地部署大模型的门槛有望进一步降低。