春节期间,DeepSeek掀起热潮,引发AI“淘金热”,主流电商平台相关产品销售火爆,仿冒网站众多,官方紧急声明。节后,许多人想体验DeepSeekR1,却遭遇服务器繁忙。此时,本地部署教程在全网流行。

DeepSeek R1满血版模型参数高达671B,运行条件苛刻。于是,其蒸馏小模型受到关注,包括DeepSeek-R1-Distill-LLaMA-8B、DeepSeek-R1-Distill-Qwen-14B、DeepSeek-R1-Distill-Qwen-32B、DeepSeek-R1-Distill-Llama-70B。海外博主提供了相关配置参考。

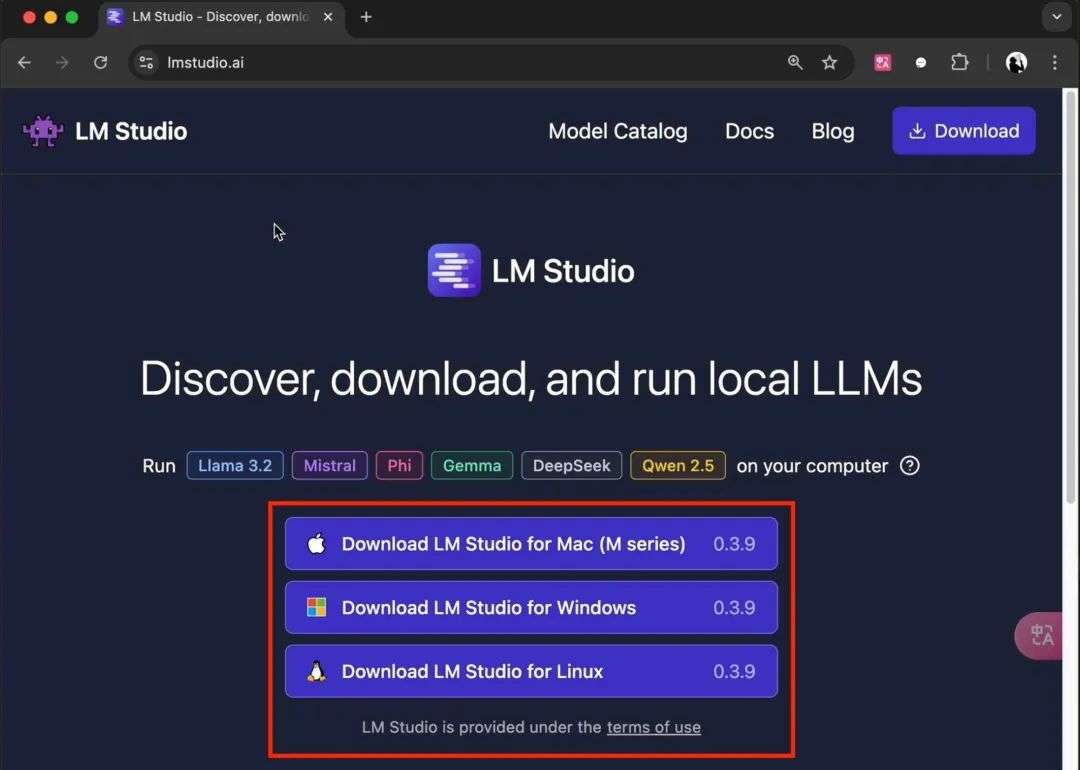

本地部署R1小模型有两种方法。一是使用LMStUdio,在官网下载安装,修改语言为简体中文后,搜索合适版本下载即可一键启动。它界面友好,无需代码,但跑大型模型对性能要求高,适合新手入门。二是使用Ollama,从官网获取安装后,在命令行输入代码指令下载模型。此方法对性能要求低,但需熟悉命令行操作,模型兼容性有限,适合进阶开发者。

在体验前,建议在LMStudio中调整推理参数,如温度、上下文溢出处理、CPU线程、采样策略等。DeepSeek研究员分享了内部调教指南。测试发现,不同参数量的小模型表现各有不同,参数小的模型回答准确率相对较低,数学计算领域差距更明显。

本地部署有优势,如敏感数据不上传、断网可用、免除APi调用费用,适合企业、开发者及注重隐私的用户。但也有弊端,知识库不更新会导致信息滞后。打造自定义知识库时,与AnythingLLM联动存在上下文窗口限制等问题。

对于绝大多数用户,使用官方版或第三方平台是较好选择。而企业用户、开发者或对数据隐私有特殊需求的用户,可考虑本地部署,但要清楚其局限性。最后附上小白QA问答,解答常见问题。