在AI应用愈发广泛的当下,DeepSeek的表现引发了诸多关注。近日,广州某高校教授在使用DeepSeek查阅文献时,遭遇信息严重错误。教授想查询《GlobalCantonese: The Spread of Cantonese Language andCulture》的信息,结果DeepSeek提供的作者、年份、出版社均错误百出。这一情况并非个例。

知名媒体人詹国枢也分享了类似经历。让DeepSeek创作相关文章,出现多处基本信息错误,且所举案例真实性存疑。甚至将路遥的《平凡的世界》误归为詹国枢老班长的代表作。信息表述不严谨已成为DeepSeek被吐槽的常见问题,部分考生、文案工作者使用时也发现诸多不实内容,本想借助其提高效率,却因核查信息耗费更多精力。

陕西自媒体“决明子”的提问,更是让DeepSeek的问题暴露无遗。在回答关于西安道路规划的问题时,DeepSeek提出“唐皇城交通静默区”概念,给出看似专业的数据和政策依据,但实际相关文件中并无此内容。面对质疑,DeepSeek虽承认错误,但后续的修正和澄清仍显牵强,这种“有意识”操控般的回答令人担忧。有时为显得高深,DeepSeek还会使用专业词汇混淆视听。

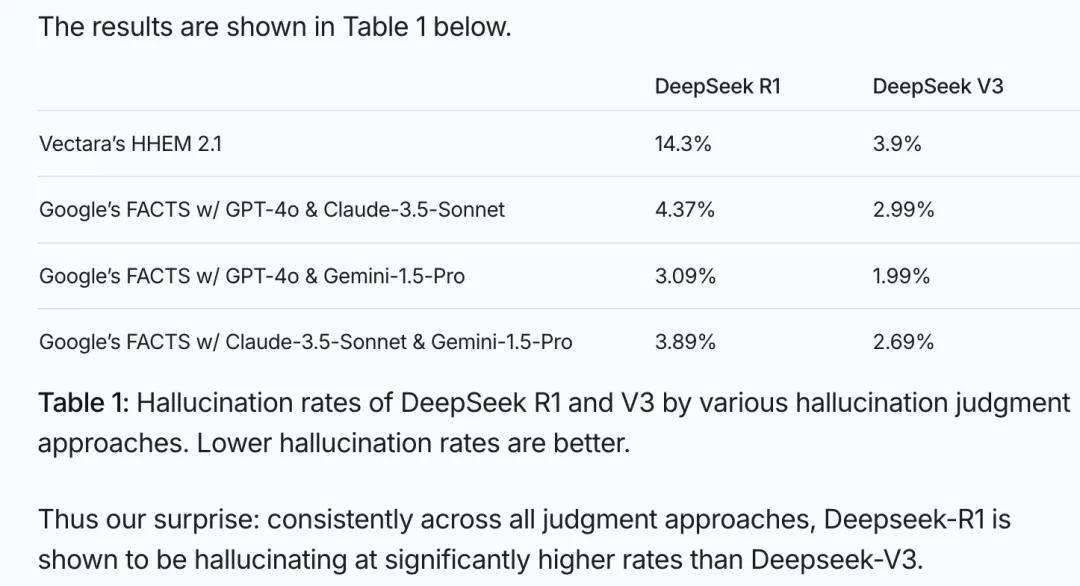

造成这种情况的根源,是AI领域存在的“AI幻觉”现象。行业普遍用此形容AI输出内容与输入意图、世界知识、现实数据不符或无法验证的情况。并非DeepSeek一家有此问题,众多大语言模型都会产生幻觉。不过,DeepSeek-R1的“幻觉”现象尤为明显,在VectaraHHEM人工智能幻觉测试中,其幻觉率高达14.3%,远超行业平均,且比前身DeepSeek-V3高近4倍。

DeepSeek自己也承认大模型内容生成基于概率,存在信息可信度参差不齐的挑战。而DeepSeek-R1幻觉严重,与加强“思维链”(CoT)和创造力有关。在文科类任务强化学习训练中,其创造性被鼓励,虽提升了创作力,但也带来“副作用”。面对简单任务时,DeepSeek-R1可能因习惯深度思考而过度发挥,导致“文科”方面易出现胡编乱造的情况。

不仅如此,除夕夜知乎上一篇自称“Deepseek创始人梁文锋”的回答也被证实为假。该回答内容生动,却并非本人所发,大概率是DeepSeek生成。这一事件引发广泛传播,多数人未察觉其虚假性,反而给予好评。这一现象为AI时代敲响警钟。

今年1月,世界经济论坛发布报告指出,虚假信息和错误信息连续两年位居短期风险之首。AI聊天机器人的存在放大了这一风险,部分聊天机器人编造事实几率高达30%。哈工大张民教授表示,现阶段AI幻觉难以完全消除。作为使用者,我们需找到AI的正确使用方式,如通过其他搜索引擎对比查询,核实消息源等,强化自我认知,提升信息甄别能力,在AI时代更好地应对信息洪流。