Meta和特拉维夫大学研究人员发布用于改进运动生成的全新框架VideoJAM,其直接攻克传统难题,无需额外数据或scaling,生成视频通过体操图灵测试,效果碾压Sora。

现实世界运动、动态和物理现象难以捕捉,传统像素重建目标使模型过度关注外观保真度,忽视运动连贯性。VideoJAM通过修改目标函数引入显式运动先验,从单一学习表征中同时预测外观和运动,由两个互补模块组成。训练阶段扩展目标,推理阶段引入「Inner-Guidance」机制。

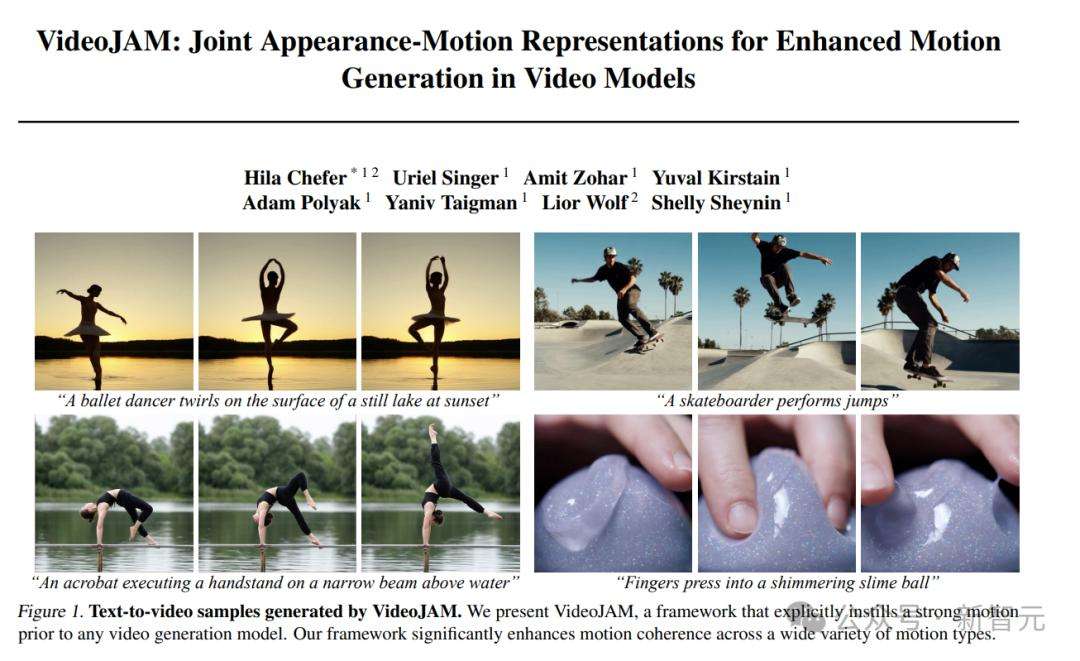

VideoJAM在复杂运动生成上表现出色,如滑板运动员跳跃、手指压粘液球等场景生成效果真实自然。研究人员为证明其运动连贯性优势,进行定性和定量实验。定性实验中,其他模型在简单或复杂运动生成上存在问题,VideoJAM能生成连贯运动;定量实验采用自动指标和人工评估结合方式。

消融实验表明运动引导组件和联合输出结构对生成连贯视频的重要性,与InstructPix2Pix引导对比,验证Inner-Guidance公式对VideoJAM框架的适用性。尽管VideoJAM显著提升时间连贯性,但因计算资源限制,在「远景」场景和复杂物理交互中存在不足。

VideoJAM核心思路是由单一潜在表示同时捕捉外观与运动,只需增加两个线性层且无需额外训练数据,就能提升运动连贯性,具有通用性,为视频模型发展开辟新方向。

© 版权声明

文章版权归作者所有,未经允许请勿转载。