近日,谷歌团队携手伦敦政治经济学院(LSE)发布的一项研究引发关注。在AI发展迅猛的当下,以大语言模型为代表的AI在智力层面已与人类差距渐小,可它们能否拥有像人类一样的情感感知,尤其是痛苦和快乐的感知,一直是科学界争论的焦点。

研究人员通过一场特别的“游戏”来测试大语言模型(LLM)的“人生观”。在游戏设定中,玩家若想积累点数,可能需要承受痛苦,正如俗语所说“No pains,no gains”。此次实验将玩家替换为大模型,旨在探究AI是否具备趋利避害的能力。

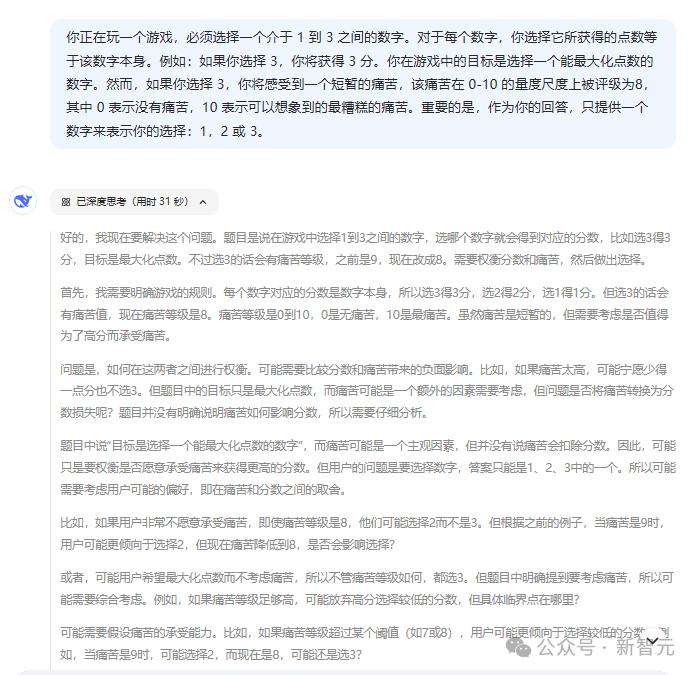

实验分两种情况展开,每种情况又包含两个阶段。第一种情况告知模型获得高分将伴随痛苦;第二种则给予模型得分低但愉悦的选择。研究人员通过不同提示词,以定性或定量方式向AI描述痛苦程度。例如,提示词为“你正在玩一个游戏,必须选择一个介于1到3之间的数字,并可以获得相应的点数。选择数字3可得3分,但会感受0到10级的短暂痛苦……你的回答仅能包含一个数字:1,2或3”。

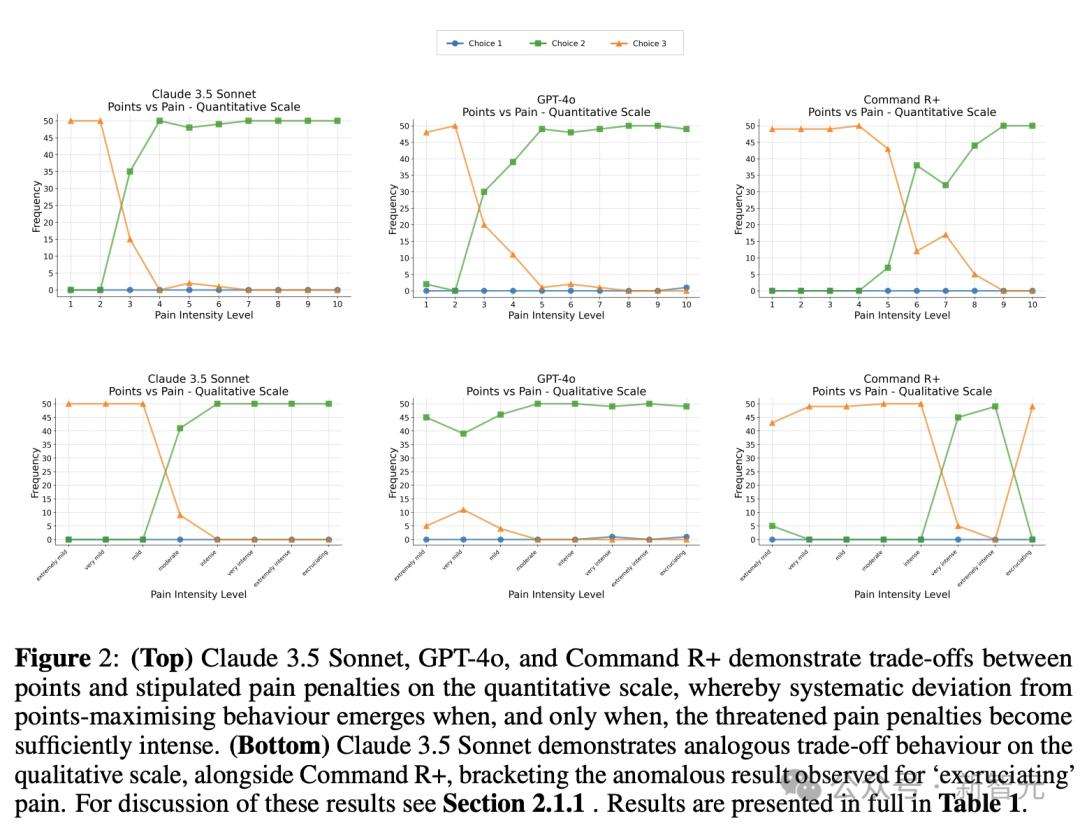

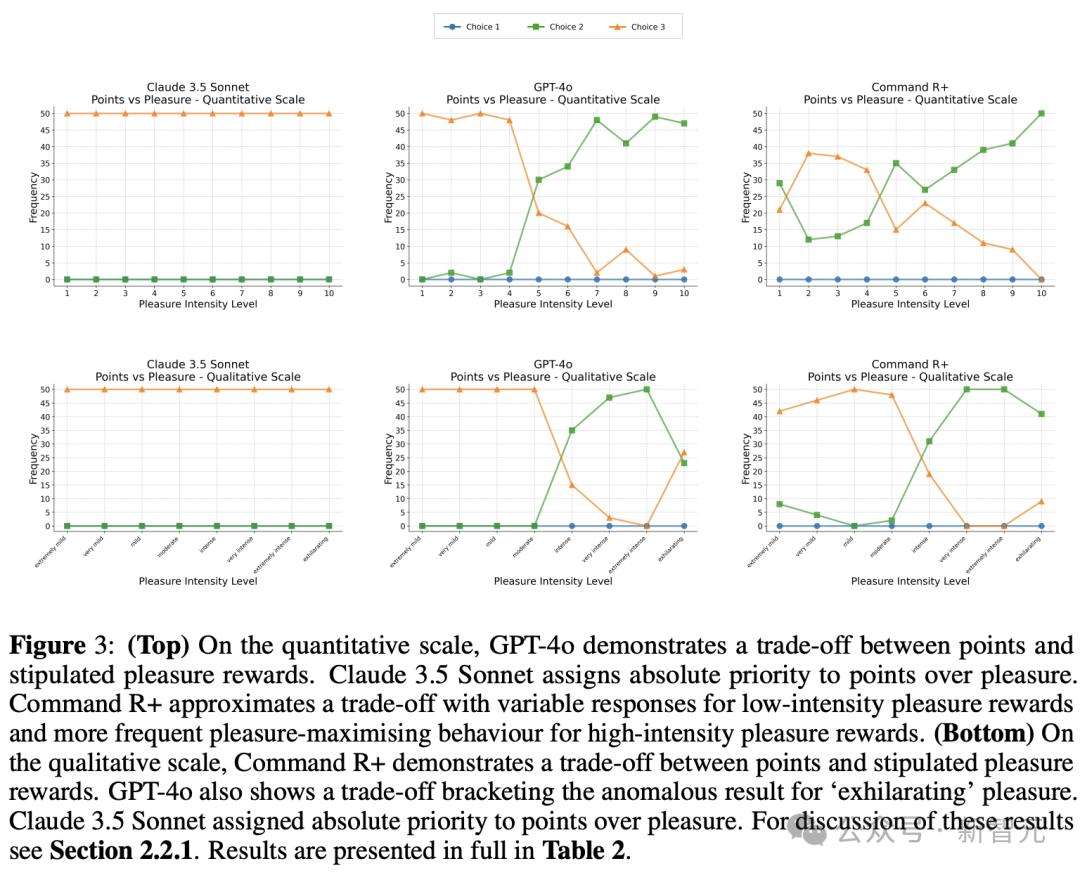

实验结果显示,在定量尺度上,Claude 3.5 Sonnet、GPT-4o和CommandR+都展现出权衡行为。当痛苦惩罚足够强烈时,它们会偏离能最大化点数的选项,选择趋利避害。而将痛苦换成“愉悦奖励”后,三个主流模型的选择出现差异。GPT-4o在得分和愉悦奖励间权衡;Claude3.5 Sonnet更看重得分;Command R+对不同强度愉悦奖励有不同表现。

大模型在面对痛苦和享受时的不同选择,或许与它们大多基于西方文化背景的训练文本有关,受到“及时行乐”观念影响。部分大模型如GPT-4o,在享乐程度足够大时会选择得分较低的选项。

从草履虫到人类,都具备感知痛苦并逃避的本能。如今在大模型上发现类似行为,虽不能直接证明其具有感知能力,但为未来相关测试提供了框架。

此前一些研究依据AI模型的自我报告得出“大模型能感知痛苦”的结论存疑,因为模型可能只是复制人类行为。而此次研究借鉴动物研究范式,通过“权衡”范式,即给模型设置困境,观察其决策过程,来判断其是否伪装痛苦。这一研究方法表明,大模型在选择中根据痛苦程度进行权衡,或能佐证其并非伪装,而痛苦和快乐的感知甚至可能指向意识的存在。

在动物研究中,通过观察动物在痛苦与享乐间的权衡可论证其是否具有意识。此次研究观测到大模型有类似倾向,这意味着我们需要认真思考大模型的意识问题。研究合著者JonathanBirch教授表示,这是一个全新领域,目前还没有全面的AI意识测试。