近期,一款名为s1的人工智能推理模型引发广泛关注。研究人员以不到50美元的云计算费用,成功训练出该模型,此消息如巨石入水,在AI领域激起千层浪。

s1模型的独特之处,首先体现在其核心支撑要素上,即s1K数据集和预算强制法。s1K数据集的构建堪称匠心独运,团队精心挑选1000个问题,涵盖数学竞赛、博士级科学、奥林匹克竞赛等多种类型,通过难度、多样性和质量三个标准严格验证。这些数据来源广泛,既有NuminaMATH等既有数据集,也有团队自创的s1-prob和s1-teasers。同时,借助谷歌GeminiFlash Thinking模型生成推理轨迹和答案,为数据集增添丰富内涵。

在测试时扩展方法上,s1团队分为并行和顺序两类,而备受关注的预算强制法,正是针对顺序类方法研发。该方法通过控制模型生成的思考标记,灵活调整模型思考过程,确保模型在合理计算量内高效运行。

经过一系列操作,团队对阿里的Qwen2.5-32B-Instruct进行s1K的监督微调并应用预算强制后,得到模型s1-32B。这一过程看似简单,实则蕴含诸多复杂细节。

然而,该模型成果在传播过程中引发诸多误解。不少人认为李飞飞团队用低价训练出媲美顶尖模型的产品,甚至存在诸多夸大说法。对此,知乎大模型优秀答主段小草进行详细剖析。

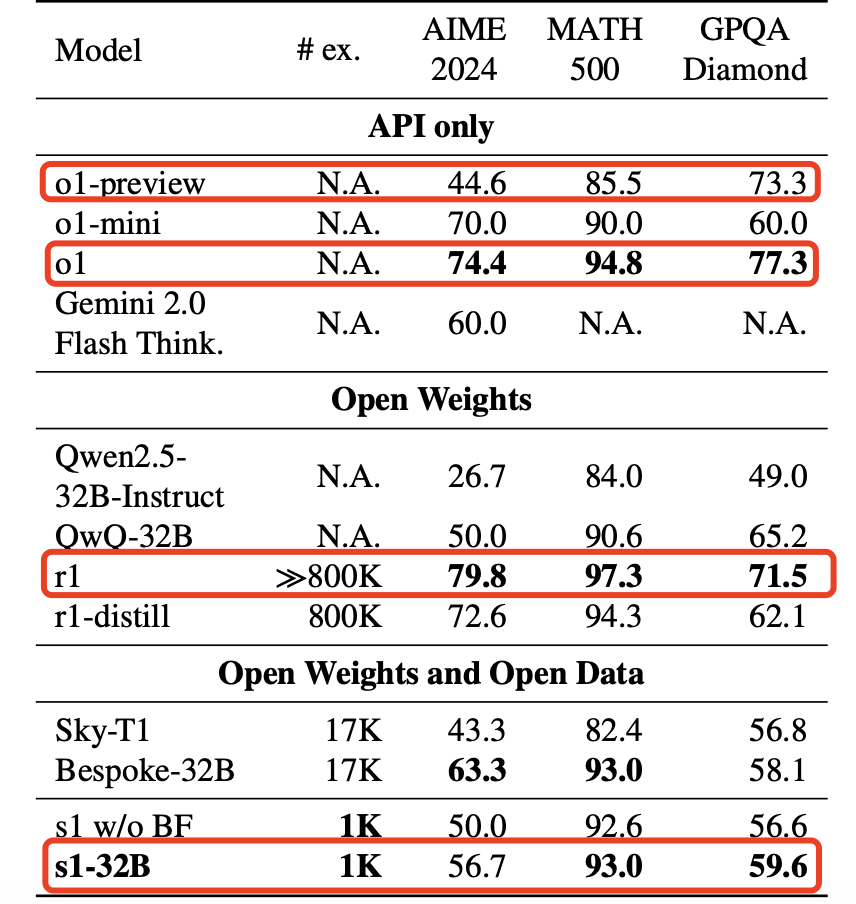

关于是否是李飞飞团队,虽有关系,但主要工作由几位共同一作承担,李飞飞更多可能是指导或挂名。在成本方面,50美元仅为最后一轮微调的GPU卡时费用,且不包括人力、数据等其他成本,同时模型并非只训一轮。在性能上,s1只能在特定测试集上超过o1-preview,与o1正式版和DeepSeekR1仍有较大差距。而训练数据与Gemini的关系,严格说并非传统‘蒸馏’概念。

尽管如此,s1模型并非毫无价值。其通过精心挑选数据和创新方法,在特定测试集上取得一定成绩,尤其在强制延长模型思考时间方面的探索,为AI发展提供新思路。

此外,近期另一篇论文《LIMO: Less is More forReasoning》也值得关注。该论文基于Qwen2.5-32B探讨测试时计算扩展,仅用少量数据示例便激发模型复杂数学推理能力,挑战传统观点。

在信息传播过程中,‘李飞飞团队’论文被不同程度曲解。从论文作者推文到AI工程师博客,再到外媒报道,信息在传播中被加工,部分内容甚至成为噱头,引发国内广泛误读。但无论如何,这些探索都推动着AI领域不断向前发展。