在使用AI尤其是DeepSeek-R1时,提示词的运用至关重要。此前关于DeepSeek-R1的提示词使用方式引发诸多疑问,本文将深入剖析。

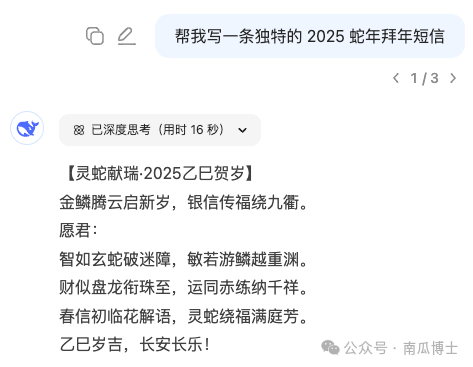

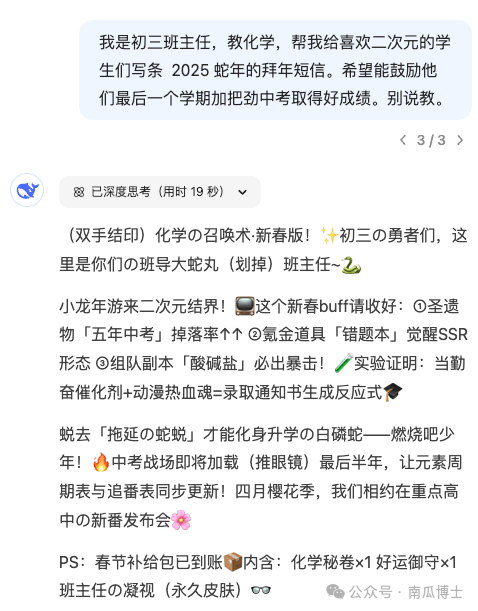

首先,大白话式提示词并非不可行,关键在于是否提供了足够多的背景信息。大模型基于人类智慧通过概率预测下一个token,许愿式的简单指令,如“给我写段XXX”,往往只能得到平庸结果。以“蛇年拜年短信”为例,简单指令得到的内容较为普通;而若用大白话清晰说明自身、对象和内容等背景信息,效果则截然不同。这表明,不是大白话不行,而是信息量匮乏的大白话难以产生理想效果,我们需要为AI提供足够多背景信息,让大模型知晓用户偏好。

提示词框架依旧具有有效性,其本质是思考的脚手架。两年前提示词工程提出多种框架,对照框架可帮助我们想起遗漏的背景信息并告知大模型。面对R1,这些辅助梳理信息的框架依然有用,但不必拘泥,可根据实际情况调整。

借助乔哈里视窗能够分析该向AI提供多少信息。通过这个工具,可清晰判断不同情形下应如何撰写提示词,明确哪些信息需告知AI,哪些无需告知。

结构化提示词对于AI“记住”和遵循指令有帮助。在ChatGPT时代,很多人青睐结构化提示词,一些平台还会自动优化大白话提示词为结构化形式。复杂内容采用结构化梳理,效果更佳,这就如同人类使用思维导图辅助记忆,将线性内容组织成树状结构,减轻记忆负担。大模型也类似,用特殊符号分块提示词,AI更容易“记住”和遵循指令。除Markdown格式,其他能清晰分块的方式,如类xml标签或随性分割线,效果也不错。不过,如果提示词不复杂,就无需如此繁琐。

在使用R1时,不要轻易在提示词里指定思考步骤,除非希望AI严格执行。以往用CoT方式写出中间过程能提升大模型表现,但对R1可能适得其反,因为R1深度思考能力强,往往能比用户想得更多。比如拜年短信案例,R1能想到很多用户未想到的内容。所以,当“如何做”的信息在乔哈里视窗“AI知道”区域时,只需说清目的即可。当然,如果希望AI严格按特定方法论执行,也可用CoT,但建议先与R1自由对话,参考其思考过程再改进步骤。

示例作为一种隐性的需求说明书,对R1依旧有效。以前提示词技巧常提到“给示例”,通过In-Context-Learning、one-shot、few-shots等方式,能明显提升大模型表现。当描述要求抽象或不准确时,添加示例可让大模型更好理解需求。为避免overfitting,例子最好多样化,还可以先与R1自由对话,挑选合适例子放入提示词。特别的是,可用简单大白话给例子,R1有能力举一反三。

提示词要区分自用还是他用、一次性还是反复用。若是自己的非重复任务,在对话中补充信息即可;只有反复使用的任务,才值得打磨高质量提示词。这样的提示词甚至可用meta-bot自动生成并优化,R1在这方面有不同之处,后续将另文介绍。

R1指令遵循能力比以往模型稍弱,可通过查看其思考过程调整提示词,强调重要内容;也可让模型分工协作,先由R1自由生成内容,再用指令遵循好的小模型整理输出。同时,避免在一条提示词中塞入过多任务,拆分任务并用工作流框架串联是更好做法。

总之,对于R1,有用的并非提示词技巧本身,而是用户自身的思考和表达。提示词技巧保障AI回复质量下限,提升上限则依赖具体内容。使用AI虽简单,但每个人可能都需提升语文、逻辑和批判性思维能力。