近日,斯坦福大学与华盛顿大学研究团队联合发布的AI训练方法S1,引发业界关注。此方法以极简的测试时缩放技术,提升语言模型推理能力,突破以往依赖庞大算力或复杂算法的局限。

S1方法的关键在于构建s1K数据集。这个仅包含1000个高质量推理问题的小型数据集,筛选标准严苛,要同时满足难度高、多样性强、质量优良。研究团队经消融实验证实,随机选择或只关注单一标准,都会使性能下滑。即使是5.9万个样本的超集训练效果,也远不及精心挑选的1000个样本,凸显数据选择的关键作用。

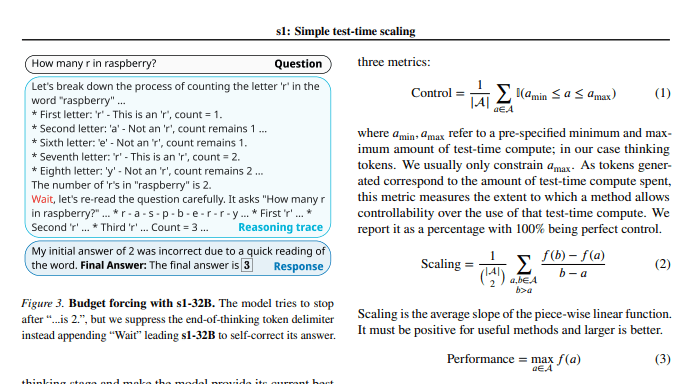

模型训练完成后,“预算强制”技术登场。通过强制终止模型思考过程或添加“等待”指令,延长思考时间,引导模型深入探索和验证,有效纠正推理错误。

实验成果显著,在s1K数据集微调及“预算强制”技术助力下,s1-32B模型在竞赛级数学问题上超越OpenAI的o1-preview模型27%。不仅如此,该模型还展现出强大泛化能力,在AIME24测试集上得分从50%提升至57%。

此研究贡献突出,提供创建高推理能力数据集及实现测试时性能缩放的简单高效方法。打造的s1-32B模型性能佳,可媲美甚至超越闭源模型,且开源、样本效率高。代码、模型和数据已在GitHub开源。

研究人员还深入开展消融实验,明确数据筛选需兼顾难度、多样性和质量;“预算强制”技术在测试时缩放方面,可控性与性能提升效果显著。此外,研究并行缩放和顺序缩放方法,引入REBASE等高级技术,为未来研究指明方向。

这项研究为AI训练领域带来低成本、高效益新思路,为AI广泛应用筑牢基础。论文地址:https://arxiv.org/pdf/2501.19393

© 版权声明

文章版权归作者所有,未经允许请勿转载。