近日,知名生成式AI创业公司Stability AI的前研究主管Tanishq Abraham撰文,对围绕DeepSeekR1的一系列谬论予以有力揭穿。DeepSeek R1作为一款开源的强推理模型,自今年1月20日开源后,便引发了全球范围内的广泛讨论与诸多猜测。

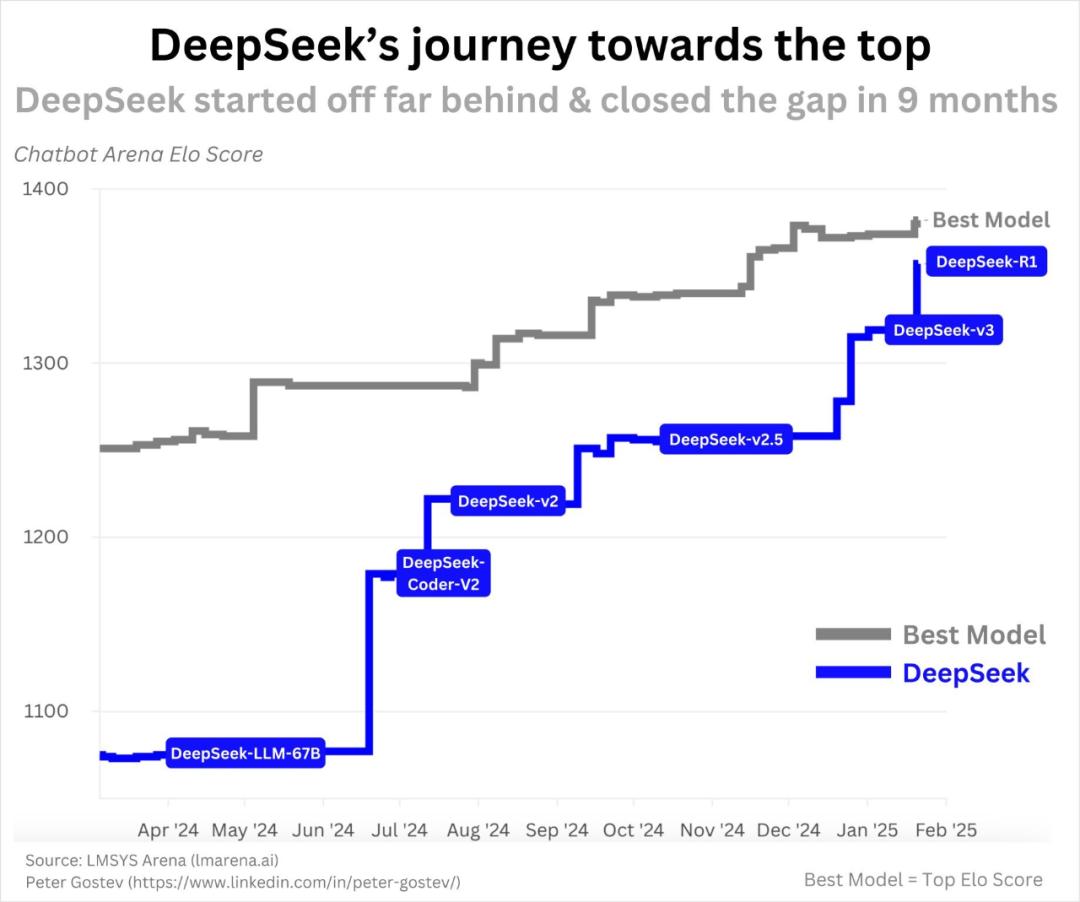

有人质疑DeepSeek是一家突然冒出来的中国公司。然而,事实并非如此。早在2023年11月,DeepSeek就发布了首个开源模型——最先进的代码LLM(DeepSeek-Coder)。在随后一年的时间里,DeepSeek持续推出新产品,R1只是其发展进程中的一环。在人工智能领域快速发展的背景下,拥有出色团队的DeepSeek取得这样的进步并不奇怪。

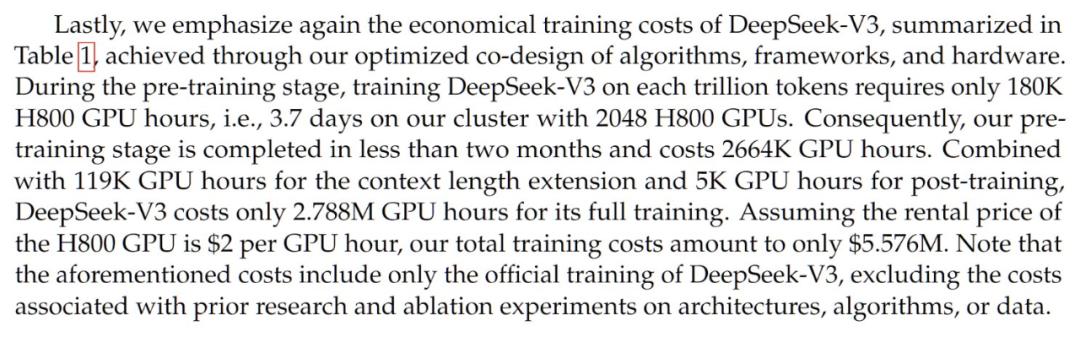

关于训练成本,有人称训练模型不可能只花费600万美元,质疑DeepSeek撒谎。实际上,600万美元这一数字最早源于DeepSeek-V3的论文,该论文比DeepSeek-R1的论文早一个月发布。DeepSeek-V3是DeepSeek-R1的基础模型,R1在其基础上增加了强化学习训练。经分析,根据GPU成本、数据集规模和模型规模估算,该成本具有一定合理性。并且,DeepSeek采用混合专家系统(MoE)架构,降低了训练成本。同时,购买GPU集群的方式、小规模实验及研究人员薪资等因素也会影响成本核算。因此,用不实信息质疑DeepSeek的低成本和运营效率是不公平的。

还有观点认为DeepSeek训练效率高,使得美国AGI公司浪费钱,对英伟达不利。但这种看法忽略了扩展率(scalinglaws)以及AGI公司的战略考量。AI领域的ScalingLaws表明,更多计算资源通常能带来更好性能。尽管存在更高效的模型,但更多计算资源仍有助于取得更好结果。并且,英伟达在AI加速芯片领域的主导地位目前难以撼动,没有理由因DeepSeek而不看好英伟达。

在创新方面,DeepSeek在语言模型设计和训练方式上有诸多亮点。例如,开发了更节省内存且性能出色的Multi-latent注意力(MHA)机制变体;展示了简单的强化学习流程,开发了更高效的GRPO算法;设计了更高效快速的多GPU训练方法DualPipe。这些创新均已开源并详细记录,为AI模型训练带来进步。

对于DeepSeek从ChatGPT吸取知识的说法,OpenAI及其员工并未提供证据。而且,蒸馏技术所需的ChatGPT完整概率信息并未公开。即便DeepSeek使用其他来源数据进行训练,也不违反服务条款。实际上,DeepSeek对o1的复现更为令人印象深刻,其在工程、效率和架构创新方面的成果不容忽视。

在中美AI竞争层面,DeepSeek的出现让中国在AI领域的地位更加凸显。尽管美国部分公司的模型目前更为强大,且有充足资源保持领先,但中国也在加大投入,竞争正日益激烈。总体而言,DeepSeekR1值得认可,其展现出的实力在AI发展历程中留下了深刻印记。