Google DeepMind在智能体时代持续发力,继去年底推出Gemini 2.0 Flash模型后,时隔两个月,Gemini2.0系列全家桶正式上新。此次发布在DeepSeek“鲶鱼效应”催化下,展现出诸多亮点。

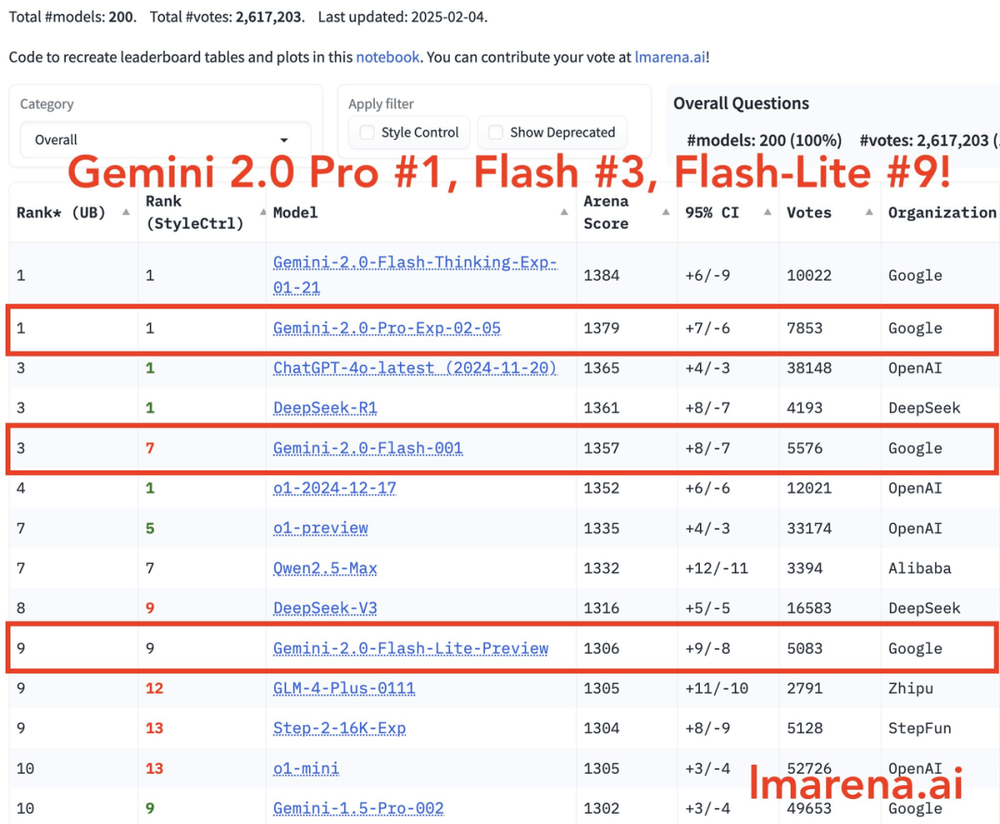

在最新的大模型竞技场中,Gemini 2.0系列各有出色表现。Gemini 2.0 Pro在所有类别中排名第1,Gemini 2.0Flash排名第3,Flash-lite凭借出色性价比跻身前十。DeepMind CEO DemisHassabis表示,该系列是性价比和性能方面的领先模型,大家可利用其强大的推理和多模态能力开展智能工作。

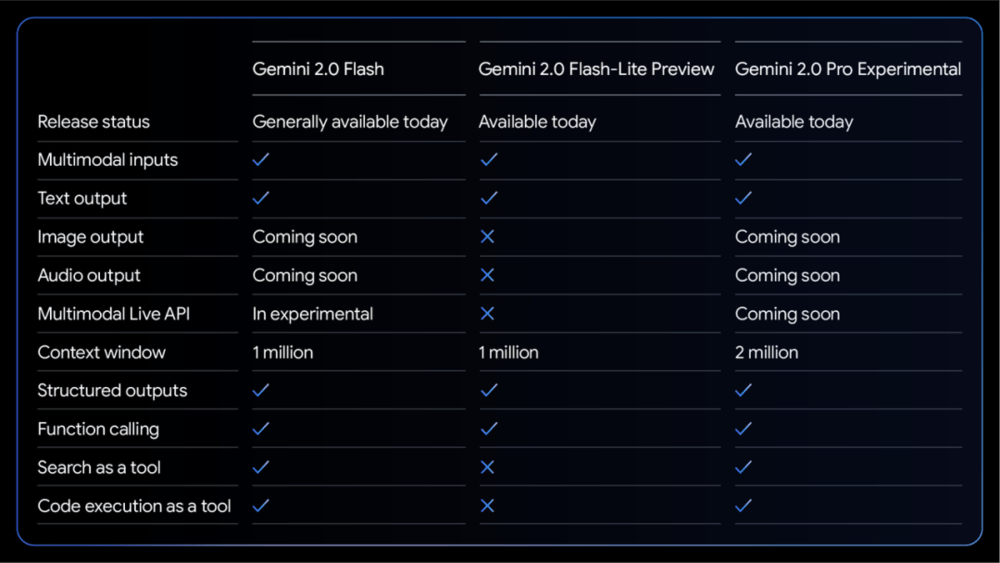

Gemini 2.0系列模型各具特色。2.0 Pro Experimental主打编码性能和处理复杂提示能力,在知识理解和逻辑推理方面表现出色;2.0Flash专门面向开发者提供API接口,支持快速构建App;2.0 Flash Thinking Experimental已在GeminiApp中开放供用户体验;2.0 Flash-Lite在保持高性能的同时实现了更优的成本效益和响应速度。

已全面发布的Gemini 2.0Flash支持多模态输入和文本输出,具备100万tokens的上下文窗口,并支持结构化输出、函数调用和代码执行等功能。其多模态实时API目前处于“beta”阶段,图像和音频输出功能将后续推出。该模型定价方案已确定,文本、图像和视频输入每百万tokens收费0.10美元,音频输入0.70美元,文本输出每百万tokens收费0.40美元。各类缓存费用也维持在较低水平。在此基础上,Google推出更具性价比的“轻量版”——Gemini2.0 Flash-Lite,虽在功能上有取舍,但保留了核心功能,定价更为亲民。

产品线顶端的Gemini 2.0 ProExperimental版本拥有200万tokens的超大上下文窗口,功能最为全能,支持多模态输入和文本输出,具备结构化输出、函数调用、搜索工具和代码执行等全方位能力。在性能测试方面,Gemini2.0系列表现可圈可点,但即便最强的Gemini 2.0 Pro Experimental版本也落后于OpenAIo3模型。不过有网友认为当前性能对比可能不完全合理,这些模型的优势在于快速响应能力和较低成本,适用于特定任务,随着新功能推出,应用场景将进一步扩展。

目前,这些新模型已在Google AI Studio和Vertex AI平台向开发者开放,Gemini高级用户也可在设备上选用。此外,随着Gemini2.0全家桶上线,网友玩出了新花样,如让其设计贪吃蛇游戏等。在Gemini发展的同时,OpenAI也在持续发力,宣布DeepResearch功能向所有Pro用户全面开放,ChatGPT的搜索功能向所有用户开放。最后,AI模型的命名问题也引发关注,目前各公司都在寻找更简单、清晰的命名方式。