在视频扩散生成领域,如何精准操控视频运动细节并保证画面质量,一直是研究焦点。来自Netflix、StonyBrook大学等机构的研究人员提出创新方法,通过结构化的潜在噪声采样实现运动控制。

研究提出的全新噪声扭曲算法,以光流推导出的结构化噪声替代传统随机噪声,具备强大的视频运动控制能力。该算法运行速度超快,能实时运行,用光流场推导的扭曲噪声取代随机的时序高斯噪声,同时保持空间高斯性。

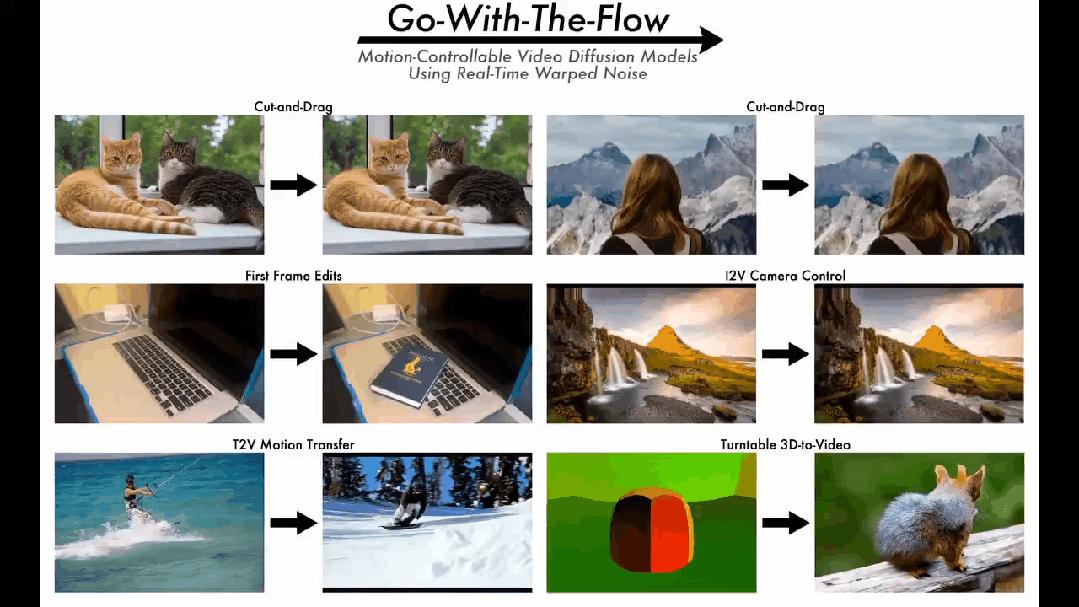

此算法实现方法简便,对训练视频做预处理生成结构化噪声,不涉及扩散模型设计,无需改变其架构和训练流程。算法高效,能用扭曲噪声以低成本微调视频扩散基础模型,为用户提供全面运动控制方案,可用于局部物体运动控制、全局摄像机运动控制以及运动迁移等场景。

Go-with-the-Flow由噪声扭曲算法和视频扩散微调两部分组成。噪声扭曲算法运行时与扩散模型训练流程互不干扰,研究团队利用该算法生成噪声模式训练扩散模型。运动控制基于噪声初始化,未在视频扩散模型中添加额外参数,简化了模型结构,提高了运行效率。

为便于大规模噪声扭曲操作,研究团队研发快速噪声扭曲算法,逐帧处理噪声,只需存储前一帧噪声和光流密度值矩阵,根据光流追踪画面扩展和收缩,实现并行处理,提高效率,且能保证噪声高斯性。

实验结果显示,该方法在保持运动一致性、渲染不同运动效果方面表现出色,在像素画面质量、运动控制精准度等方面具有显著优势。相比其他方法,本文方法在保持空间高斯性、噪声生成效率和实际应用方面可行性强,效率比实时速度快一个数量级,在多个任务和数据集的评估中表现优异。

© 版权声明

文章版权归作者所有,未经允许请勿转载。