近期,一家名为DeepSeek的AI公司引发了全球关注。它以极低的开发成本,在开源和服务免费的情况下,展现出强大实力,令众多行业人士为之惊叹。知名投资人“木头姐”凯茜·伍德直言其加剧了人工智能的成本崩溃,这一现象也引发了关于中美AI领导地位更替的思考。

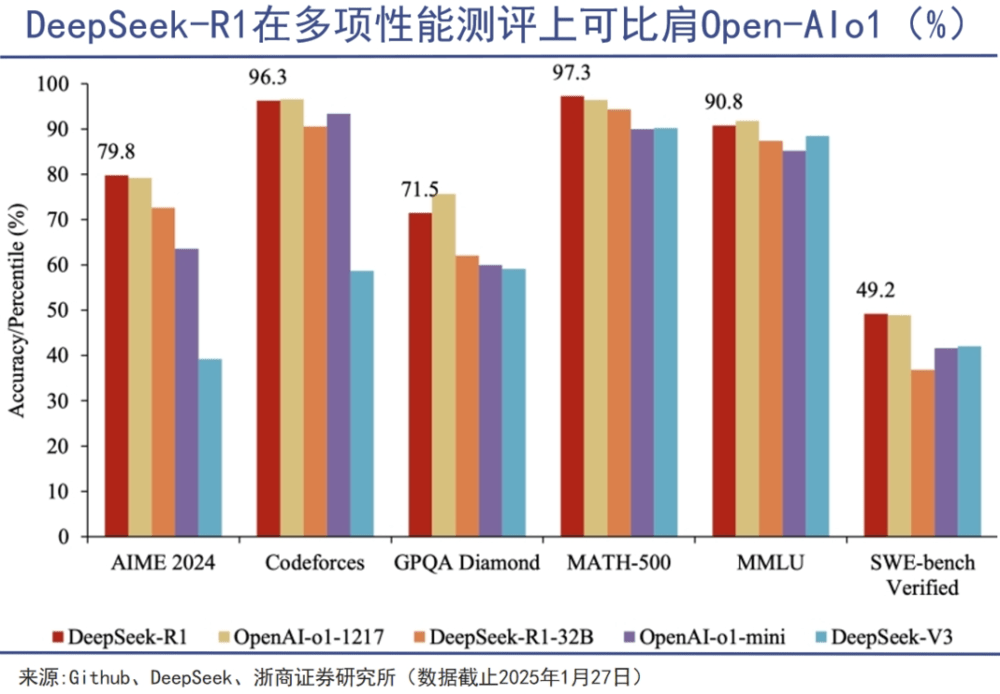

DeepSeek的颠覆性创新体现在极致的效率革命上。1月20日发布的DeepSeek-R1模型系列成绩斐然,在大模型排行榜ChatbotArena上,其基准测试排名升至全类别第三,与Chat[GPT-4](https://ai-kit.cn/sites/1023.html)o最新版并驾齐驱,在风格控制类模型分类中还与OpenAI-o1并列头名。

虽R1模型训练成本未公布,但据DeepSeekV3技术报告,V3模型训练总计只需278.8万GPU小时,在2048块H800集群上训练约2个月,成本仅557.6万美金。有传言称R1模型训练成本与之相当,可参数规模达到6710亿。与之对比,GPT-4o模型训练成本约1亿美元,MetaLlama 3系列模型训练需要多达3930万H100 GPU小时,而DeepSeek训练成本仅约为Llama 3的7%。

这种低成本高成效的能力源于其自研的MLA和MOE架构,同时R1模型采用数据蒸馏技术,通过一系列算法提炼原始数据,提升训练效率。模型蒸馏广泛应用于提高AI效率与降低成本,这让DeepSeek如同用更高效学习方法获得优异成绩的学生,而OpenAI则类似依赖题海战术的学习者。此外,OpenAI训练依赖人工,数据标注成本高昂,近期还指责DeepSeek团队“违规复制”,却始终未提供证据。实际上,数据清洗和精炼同样是提升模型能力的关键,DeepSeek通过创新训练方法改变了堆砌算力的行业共识。

半导体领域遵循摩尔定律,AGI行业则沿Scaling Law演进。ScalingLaw被视为大模型训练的“第一性原理”,即模型性能与规模呈正相关。然而,DeepSeek的出现打破了这一定律,至少让其边际效益放缓。这启示人工智能产业不再单纯追求大规模算力投入,而是转向模型架构和工程优化的结合。

DeepSeek带来的“范式转移”,破除了科技大厂的技术壁垒和资本比拼惯例。作为回应,OpenAI紧急上线新一代推理模型o3系列的mini版本并免费开放基础功能。奥特曼承认在开源问题上站在了历史错误一方。而字节跳动、微软等大厂在AI赛道投入巨大,美国政府联合多家企业启动“星际之门”项目,计划高额投资。此前,美国大厂为下一代模型补充算力,奥特曼甚至计划筹集巨额资金建设超级数据中心和芯片制造厂。但DeepSeek改变了这种超大规模扩张算力的行业发展路径,同时也出现了是否应彻底放弃算力建设的讨论。

从国家算力战略部署来看,我国算力基础设施尚处初步搭建阶段,远未过剩。一方面,DeepSeek虽受欢迎,但随着访问量飙升,其深度思考和联网搜索功能出现宕机情况,且移动应用上线18天就有1600万次下载。另一方面,DeepSeek目前功能有限,未涉及图片、音频和视频生成领域,未来若突破文本范畴,对算力和前期训练成本的投入将大幅增加。其他大模型公司情况类似,随着用户增长和产品线丰富,都需扩张算力。目前国内投资机构积极对接DeepSeek,显然对其发展有清晰判断。

目前算力建设已成为国家级战略。我国算力基础设施规模占全球26%,名列第二。工信部数据显示我国算力总规模和在用算力中心机架总规模可观。相关计划指出到2025年我国算力规模将进一步提升,“东数西算”工程已取得一定进展,国内已建、在建智算中心众多,国产芯片厂商受到关注。这些大规模部署和研发投入具有重要战略意义。

DeepSeek以低成本开发出优质产品,体现了中国在资源匮乏条件下实现工业现代化的独特智慧。在中美AI竞争中,中国企业以领先或颠覆者身份出现令人吃惊,但我们仍需保持冷静。就像梁文锋所说,这只是中国公司以创新贡献者身份加入全球创新游戏。而算力基础设施仍是人工智能时代不可或缺的资源。