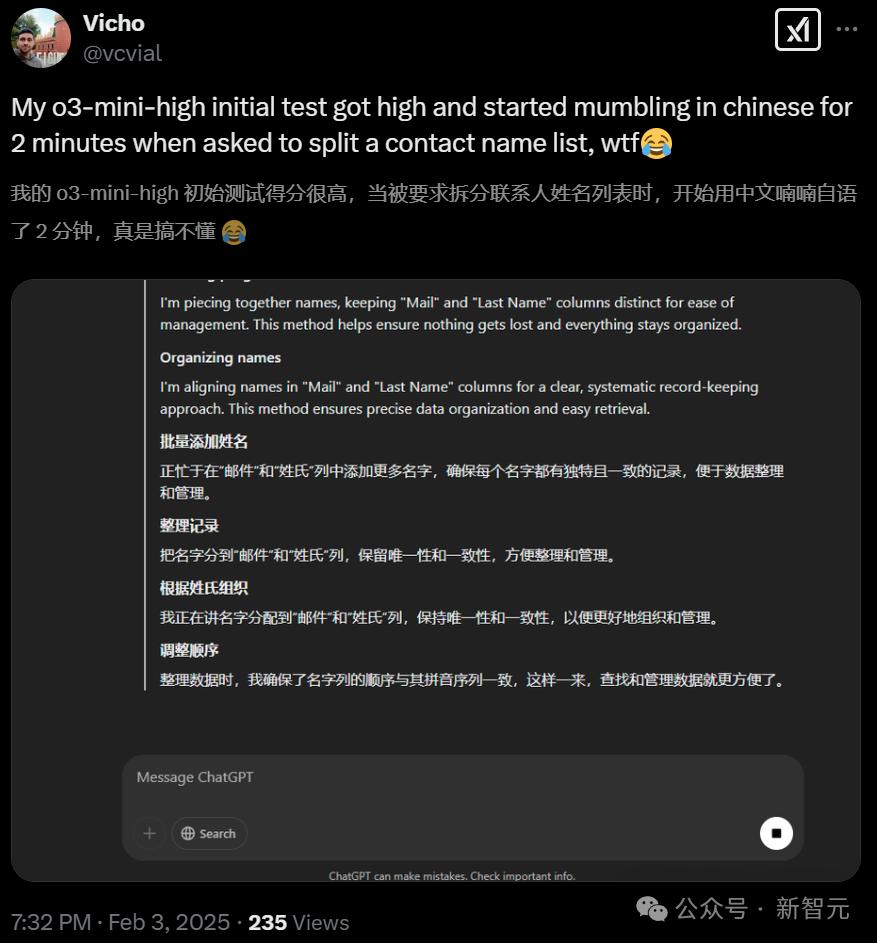

近日,国外网友有了惊人发现:美国顶尖模型之一的o3-mini-high,在无用户干预的情况下,频繁使用中文进行推理。即便用俄语提问,它也会用中文思考,这一现象让网友怀疑OpenAI是否在借鉴中国的DeepSeek模型。

其实,这并非OpenAI模型首次出现此类情况。去年2月,就有开发者在OpenAI开发者社区报道过类似的语言混合问题,OpenAIo1在推理模型方面也存在此类现象。不仅如此,谷歌的Gemini也曾出现混杂德语的情况。

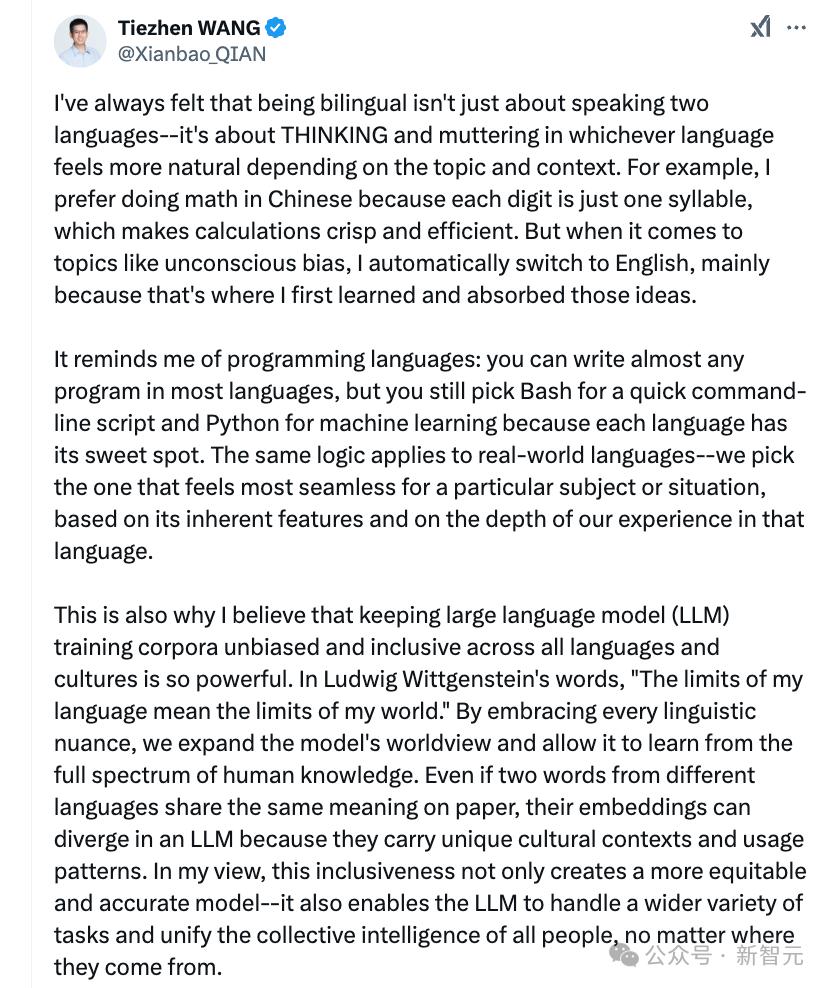

那么,o3-mini-high为何在推理过程中会大量使用中文呢?阿尔伯塔大学助理教授MatthewGuzdial认为,模型并不理解语言,它处理的只是文本。Hugging Face的工程师TiezhenWang则觉得,这可能是训练期间建立了特殊关联。网友Someone Kong分析,或许是因为中文更短,在强化学习中能获得更多奖励。

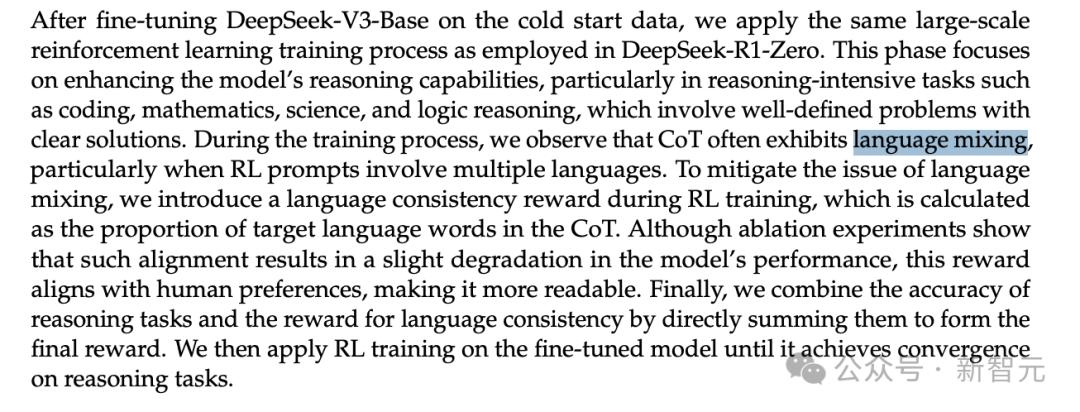

DeepSeek在研究中发现,强化学习提示词涉及多种语言时,思维链常出现语言混杂现象。为解决这一问题,他们在RL训练中引入“语言一致性奖励”,虽会使模型性能稍有下降,但输出更符合人类偏好。然而,“语言混杂”问题目前仍亟待解决,DeepSeek-R1也只是针对中文和英文进行了优化。

事件发酵后,奥特曼于2月3日表示,OpenAI“没有计划”起诉DeepSeek。但值得注意的是,OpenAI本身正面临多项知识产权侵权指控,主要与模型训练时使用受版权保护的内容有关。

© 版权声明

文章版权归作者所有,未经允许请勿转载。