当DeepSeek和o1/o3一类推理大模型不断带来震撼时,其弱点也开始被关注。腾讯AI实验室、苏州大学和上海交通大学的研究团队,针对开源的DeepSeek-R1和QwenQwQ系列模型展开研究。

研究发现,在面对高难度问题时,推理大模型存在Underthinking(欠思考)现象,如同“三心二意的学生”,频繁切换解题思路却不深入探索,导致失败。通过分析AI的错误答案,发现模型常早期走上正确路线,却“浅尝辄止”,后续生成的大量tokens对解题无用,既浪费计算资源又降低答案正确率。

为系统分析,团队在MATH500、GPQADiamond和AIME2024等测试集上对类o1模型如QwQ-32B-Preview、DeepSeek-R1-671B等进行实验。结果显示,类o1模型在错误回答中比正确回答多消耗225%的token,思维切换频率增加418%。

研究团队开发评估框架,发现超70%的错误回答至少包含一个正确思路,超50%的错误回答中有10%以上思路正确。但模型往往未深入探索正确思路,如某例子中,模型启动正确解释后,未深入分析,频繁切换思路,消耗大量token仍未得出正确答案。

基于此,研究人员提出量化Underthinking程度的指标(UnderthinkingMetric),通过测量错误答案中的token使用效率评估推理效率。实验表明,所有测试的类o1模型都存在思维不足问题,不同数据集上模型准确率与思维不足关系各异。

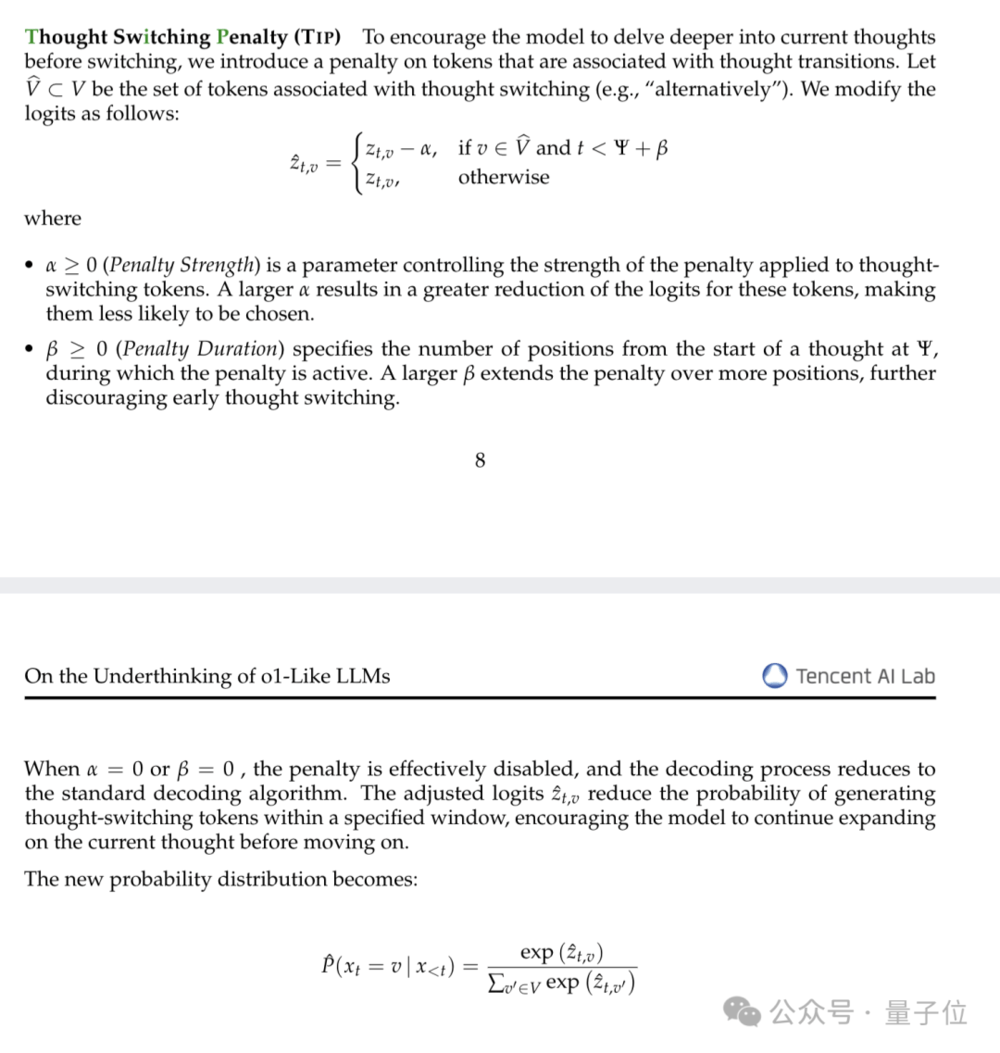

理解思维不足现象对开发优秀模型至关重要。为让模型“沉下心来钻研”,研究者提出“思路切换惩罚机制”(Thought SwitchingPenalty,TIP)。其原理类似考试定规矩,技术上对触发思路切换的关键词施加惩罚,降低其生成概率。实验显示,加入TIP能提升模型数学测试准确率,降低UTScore,且无需重新训练模型,仅调整解码策略。

几乎同时,UC Berkeley教授Alex Dimakis分享类似观察,提出“简洁解码”(Laconicdecoding)方法,并行运行5次模型选tokens最少的答案。初步实验显示,该方法在AIME2024测试上能提高6%-7%的准确率,比ConsensusDecoding更好更快。