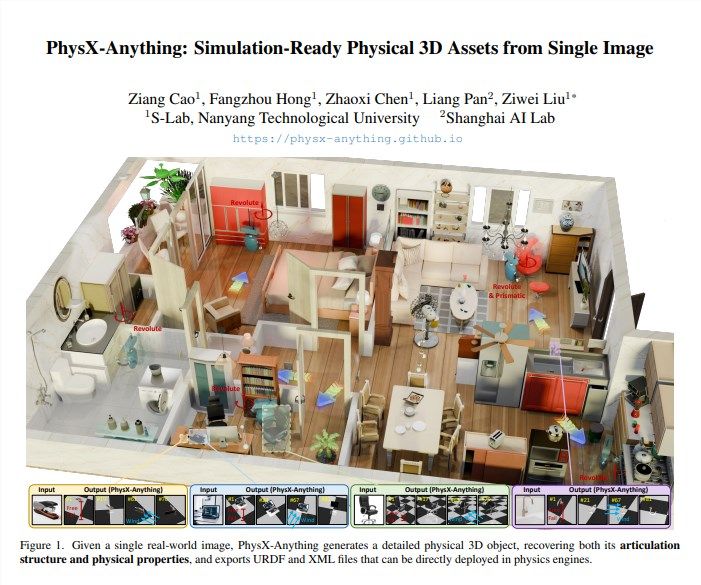

机器人政策训练中,高质量仿真3D资产的缺乏一直是瓶颈——人工建模耗时久,传统图像生成方法常因“视觉优先”忽视物理属性,导致资产导入仿真环境后出现运动失真、碰撞错误等问题。11月,南洋理工大学与上海人工智能实验室联合开源的PhysX-Anything框架,为这一痛点提供了新解法:仅需单张RGB图像,即可生成包含几何结构、关节机制及物理参数(质量、质心、摩擦系数等)的完整3D资产,直接导入MuJoCo、Isaac Sim等仿真平台用于机器人训练。

三大技术设计:兼顾物理真实性与生成效率

PhysX-Anything的核心优势源于三项针对性创新:

- “物理优先”的粗到细流程:先预测物体整体物理属性(如质量分布、摩擦系数),再在组件层面细化几何结构与关节活动限制。这种逻辑避免了视觉生成常见的物理失真——比如不会因追求外观相似让椅子腿质心偏移,导致仿真时倾倒。

- 压缩式3D表示方法:将物体的面信息、关节轴及物理属性编码为8K维 latent向量,推理时一次解码即可完成全部信息生成。相比现有SOTA方法,推理速度提升2.3倍,解决了实时生成的效率瓶颈。

- 显式物理监督机制:团队为数据集补充12万组真实物理测量数据(如物体质心、惯性矩),训练时引入质心损失、惯性损失及碰撞盒损失函数。这种“从数据到训练”的全链路约束,确保生成资产的运动规律与真实世界一致。

测试验证:精度与实用性双达标

在Geometry-Chamfer(几何精度)和Physics-Error(物理误差)两项核心指标上,PhysX-Anything显著优于ObjPhy、PhySG等近期方法:几何误差降低18%,物理误差降低27%。具体数值显示,生成资产的绝对尺度误差小于2厘米,关节活动范围误差小于5度——用它生成的宜家家具、厨房工具等资产,能在Isaac Sim中精准模拟真实场景。

真实场景测试更凸显实用性:将生成资产导入Isaac Sim后,机器人抓取成功率提升12%,训练步数减少30%——无需额外调整参数,就能直接用于政策学习,大幅降低训练前期准备成本。

开源与未来:向动态场景扩展

目前,PhysX-Anything的代码、预训练权重、数据集及评估基准已在GitHub开放。团队计划2026年第一季度推出2.0版本,支持视频输入——届时可从动态视频中预测物体组件的时间轨迹,为机器人在动态场景(如物体坠落、工具操作)中的政策学习提供更丰富资产支持。

© 版权声明

文章版权归作者所有,未经允许请勿转载。