扩散语言模型的潜力与落地困局

作为人工智能领域的新兴技术路线,扩散语言模型将文本生成重构为“从随机噪声中逐步去噪、恢复完整序列”的过程,凭借**高并行性、全局视角、结构灵活**三大特性,被视为通向通用人工智能(AGI)的重要潜在路径。但长期以来,这一技术受限于高算力消耗、KV缓存失效、并行解码困难等问题,推理效率始终无法满足产业级应用需求,其理论潜力难以转化为实际价值。

dInfer登场:针对性破解扩散模型推理瓶颈

近日,蚂蚁集团正式开源行业首个专门针对扩散语言模型设计的高性能推理框架——**dInfer**,通过模块化架构与精准优化,直接击破这一技术落地的核心障碍。

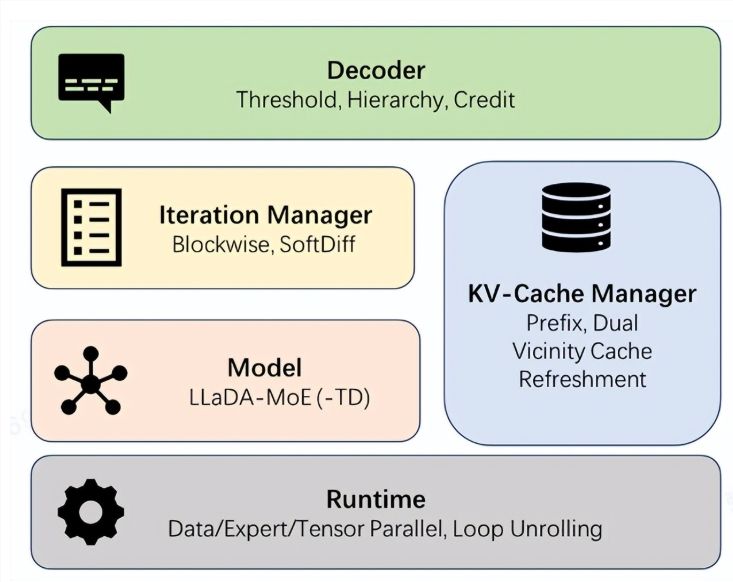

dInfer的核心设计围绕“解决扩散模型固有痛点”展开,构建了四大核心模块:**模型接入、KV缓存管理、扩散迭代管理、解码策略**。这种类似“乐高积木”的模块化结构,让开发者可根据需求灵活组合、优化各模块,并在统一平台完成标准化性能评测,大幅降低了扩散模型的开发与部署门槛。

实测数据:推理速度实现10倍级突破

在搭载8张NVIDIA H800 GPU的节点上,dInfer的性能得到了直观验证:

- 与NVIDIA官方Fast-dLLM框架相比,dInfer在相同性能要求下,单轮推理速度达**1011 Tokens/秒**(Fast-dLLM仅63.6 Tokens/秒),平均速度**681 Tokens/秒**,是前者的**10.7倍**;

- 即便对比基于行业领先推理框架vLLM运行的传统autoregressive模型Qwen2.5-3B,dInfer的推理速度仍领先**2.5倍**。

这是开源社区中,扩散语言模型推理速度首次显著超越传统autoregressive模型,标志着这一技术在实用化进程中迈出关键一步。

从科研到产业:dInfer打通最后一公里

蚂蚁集团表示,dInfer的开源是连接前沿科研与产业应用的关键节点。通过解决扩散模型的推理效率问题,这一框架将推动原本停留在实验室的技术走向金融、零售、服务等实际场景,真正释放扩散语言模型的潜力。

未来,蚂蚁集团将联合全球开发者、研究者,基于dInfer探索扩散模型的更多可能性,共同构建更高效、开放的AI生态。

© 版权声明

文章版权归作者所有,未经允许请勿转载。