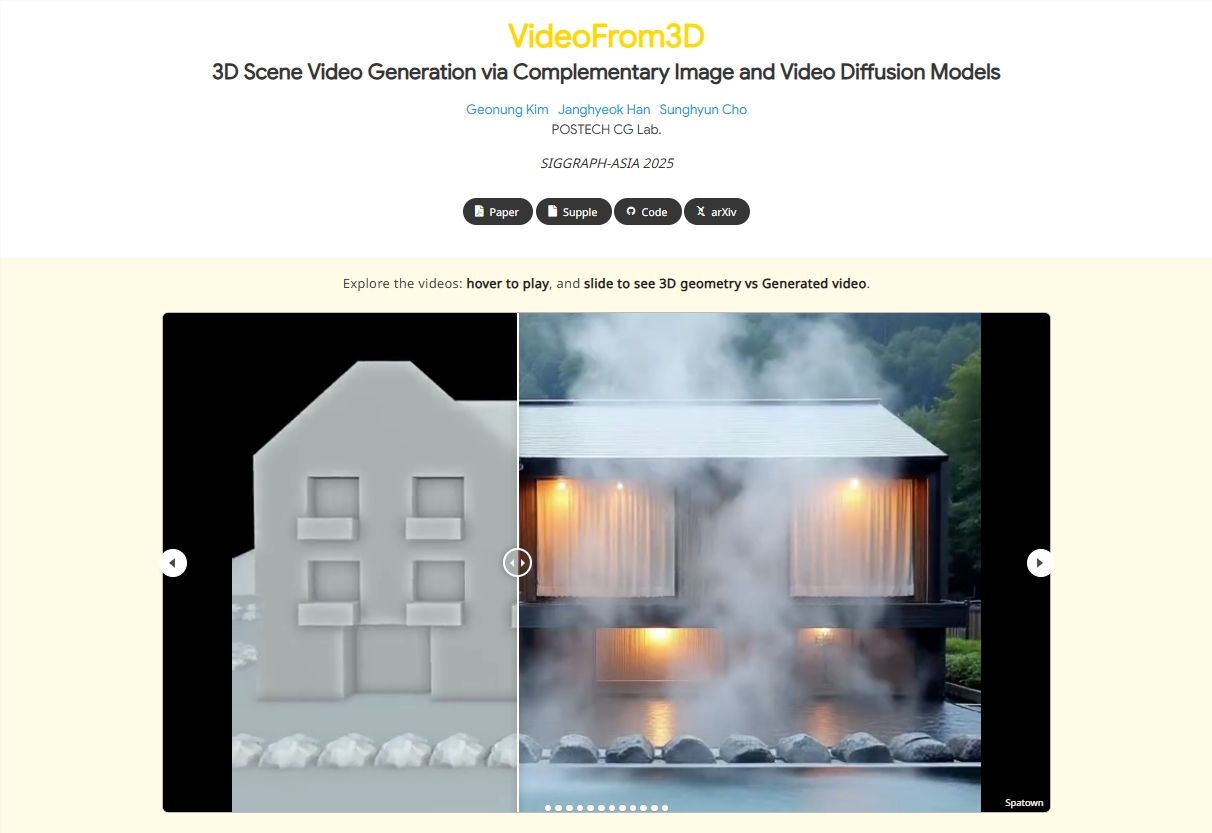

3D场景视频创作长期面临数据依赖重、流程复杂的痛点——传统方法需海量3D-自然图像配对数据,且需手动调整多视图一致性与运动流畅度,这让中小团队难以快速产出高质量内容。近日推出的VideoFrom3D框架,通过融合图像与视频扩散模型,为这一痛点提供了全新解决方案:无需依赖昂贵配对数据集,仅需粗糙几何结构、相机路径及参考图像,即可生成高真实感、风格一致的3D场景视频。

核心逻辑:双模块扩散模型融合解决协同难题

VideoFrom3D的核心是双模块架构,通过图像与视频扩散模型的互补融合,解决复杂场景中的生成难题。其中,稀疏锚点视图生成(SAG)模块基于参考图像与粗糙几何结构,利用图像扩散模型生成跨视图一致的高质量锚点视图,确保视觉细节与风格统一;几何引导生成插值(GGI)模块则依托视频扩散模型,以锚点视图为基础插值生成中间帧,通过流场相机控制与结构引导,实现运动流畅性与时间维度的一致性。这一设计规避了传统视频扩散模型在复杂场景中面临的视觉质量、运动建模与时间一致性协同难题,无需任何3D-自然图像配对数据即可产出高保真视频。

技术突破:‘零配对’策略降低创作门槛

与此前依赖海量标注数据的3D生成方法不同,VideoFrom3D的‘零配对’策略是其最大亮点。该框架仅需三类输入即可合成完整视频序列:粗糙几何结构(如简单网格或点云)定义场景的基本形态,相机路径规划视角的运动轨迹,参考图像提供风格与视觉模板。这一设计不仅彻底消除了对标注数据的依赖,更支持风格变体与多视图一致性——无论是室内家居场景还是户外自然景观,都能快速生成风格统一的视频内容。

实验结果验证了这一策略的有效性:VideoFrom3D在基准测试中优于现有基线模型,尤其在复杂动态场景中表现突出。生成视频达到专业级水准,运动自然流畅,风格高度一致,为3D图形设计注入了‘即插即用’的创作活力。

应用前景:加速多领域3D内容创作效率

VideoFrom3D的推出将对3D图形设计、影视特效、虚拟现实等领域产生深远影响。在3D设计领域,设计师可从草图快速迭代至成品视频,大幅缩短制作周期;影视特效行业能更高效地构建虚拟场景,降低特效制作成本;游戏与AR/VR开发中,开发者可轻松搭建沉浸式体验原型,加速产品迭代。

更关键的是,这一框架推动了AI创意工具的平民化。以往仅大型团队能负担的3D视频生成能力,如今中小团队通过VideoFrom3D即可获得——无需投入大量资源获取标注数据,只需简单输入就能产出高质量内容,拓展了创意的边界。

VideoFrom3D不仅是一款技术框架,更标志着3D内容生成范式的转变。它用‘零配对’策略与双模块扩散模型融合,解决了传统方法的核心痛点,让3D场景视频创作从‘数据依赖型’转向‘创意驱动型’。未来,随着技术的进一步优化,这一框架有望成为3D内容创作的基础工具,推动AI在创意领域的普及,让更多创作者用上高效、低成本的生成工具。