企业与开发者对AI视觉推理能力的需求日益迫切,但大模型的高算力成本、慢推理速度往往成为落地阻碍。近日发布的Moondream 3.0(预览版),以“9B总参数、仅2B激活参数”的轻量混合专家(MoE)架构,在保持推理速度与部署灵活性的同时,实现了超越GPT-5、Gemini等主流模型的视觉推理能力,为AI视觉领域提供了“小而强”的新解法。

轻量架构解决大模型痛点:9B参数实现“激活即高效”

Moondream 3.0的核心创新在于混合专家(MoE)架构设计——总参数虽达9B,但仅激活2B参数参与推理,既保留了大模型的能力边界,又将推理速度维持在与前版本相当的水平,大幅降低部署成本。配合集成的SigLIP视觉编码器,模型支持多裁剪通道拼接,能以更高效的token处理高分辨率图像;2048维隐藏层、自定义SuperBPE tokenizer,以及融合位置与数据依赖温度缩放的多头注意力机制,进一步强化了32K长上下文建模能力,适配实时交互与智能体工作流。

该架构延续自Moondream2的“上采样”初始化方法,训练仅用450B token(远低于主流模型的万亿级),却实现了性能不妥协。目前开发者可通过Hugging Face直接下载,支持云API与本地运行,仅需24GB+显存的NVIDIA GPU;量化版本与Apple Silicon支持将在近期推出,进一步降低硬件门槛。

从“识别”到“推理”:视觉能力实现质的飞跃

相较于今年初发布的擅长验证码识别的Moondream2,3.0版本的视觉技能从“单一任务”升级为“全场景覆盖”——开放词汇目标检测、点选、计数、caption生成、OCR等能力俱全,还支持JSON数组等结构化输出(如提取宠物ID、毛色、项圈颜色等信息)。在UI理解、文档转录、目标定位等专业场景中,模型表现尤为突出:

- COCO目标检测得分跃升至51.2,较前版本提升20.7%;

- OCRBench成绩从58.3升至61.2,文档转录准确率显著提升;

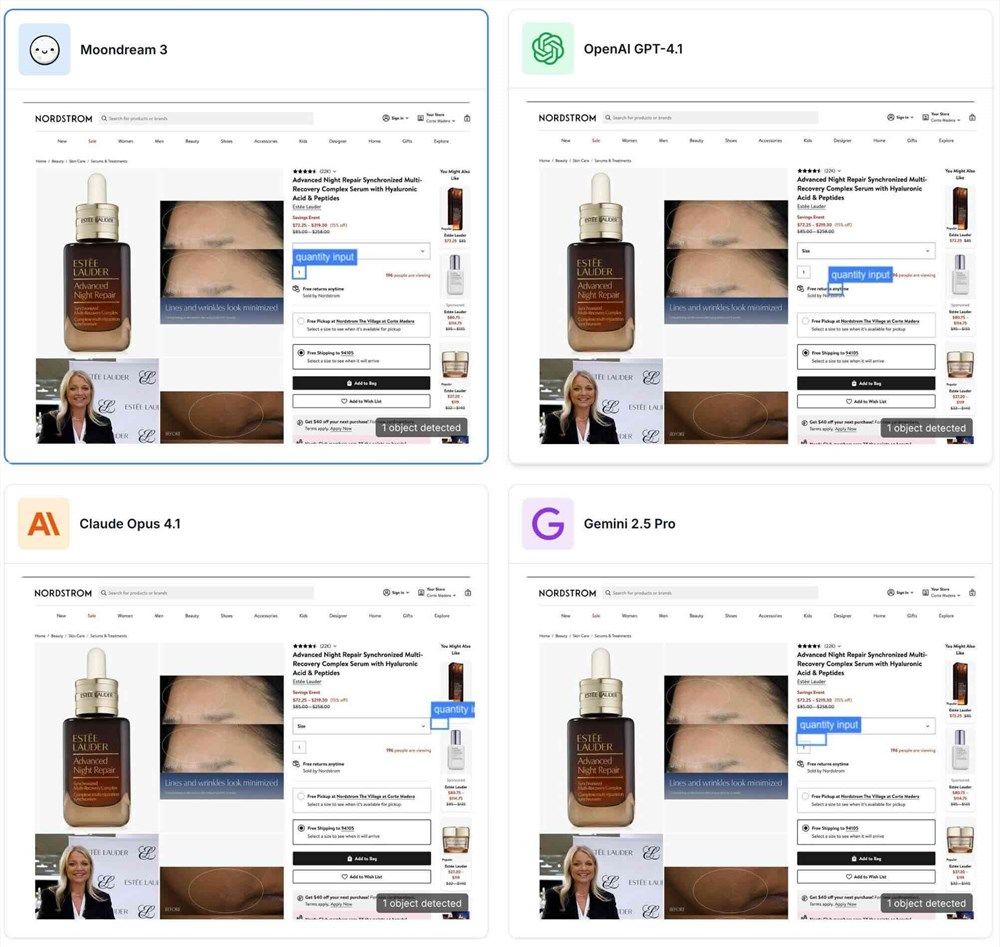

- ScreenSpot UI F1@0.5达60.3,能精准定位购物网站数量输入框等UI元素。

实际测试中,模型能轻松应对复杂场景:识别穿紫色袜子的行人、标记瓶装物体、推荐意面适配餐具,甚至完成动态跟踪与问题解答。这些能力不仅适用于安全监控、无人机巡检,更延伸至医疗影像分析、企业文档处理等专业领域,推理速度较主流大模型快数倍,显著降低运营成本。

开源+轻量:成为边缘与实时场景的“首选AI”

作为开源模型,Moondream3.0践行“无需额外训练、无需真值数据、无需重型基建”的理念——开发者仅需输入提示,即可调用模型的视觉理解能力。目前已在机器人语义行为、移动设备、Raspberry Pi等边缘场景落地,适配边缘计算对“低延迟、低算力”的需求。

相较于国内Qwen系列等开源VL模型,Moondream3.0在视觉推理精度与结构化输出能力上更具优势。未来团队将持续优化推理代码、提升基准测试成绩,推动量化版本与多硬件适配,让“小模型”覆盖更多企业与开发者的实际需求。