最新发布的Moondream3.0预览版,以“高效参数利用+强视觉推理”的组合成为开源视觉大模型领域新焦点——这款总参数达90亿的模型,仅需激活20亿参数就能完成复杂视觉任务,既兼顾性能又降低计算负担,精准回应了开发者对“轻量且强能力”模型的需求。

支撑这一效率的核心是技术架构设计:依托混合专家(MoE)架构,Moondream3.0将计算资源集中于关键任务;搭配32K上下文长度,适配实时交互、智能体工作流等长序列场景;创新的SigLIP视觉编码器实现高分辨率图像处理与多裁剪通道拼接,结合定制高效SuperBPE分词器与多头注意力机制,进一步强化长上下文建模能力。值得注意的是,尽管训练数据仅约45亿tokens(远低于同类模型的万亿级规模),模型仍凭借架构优化实现性能突破。

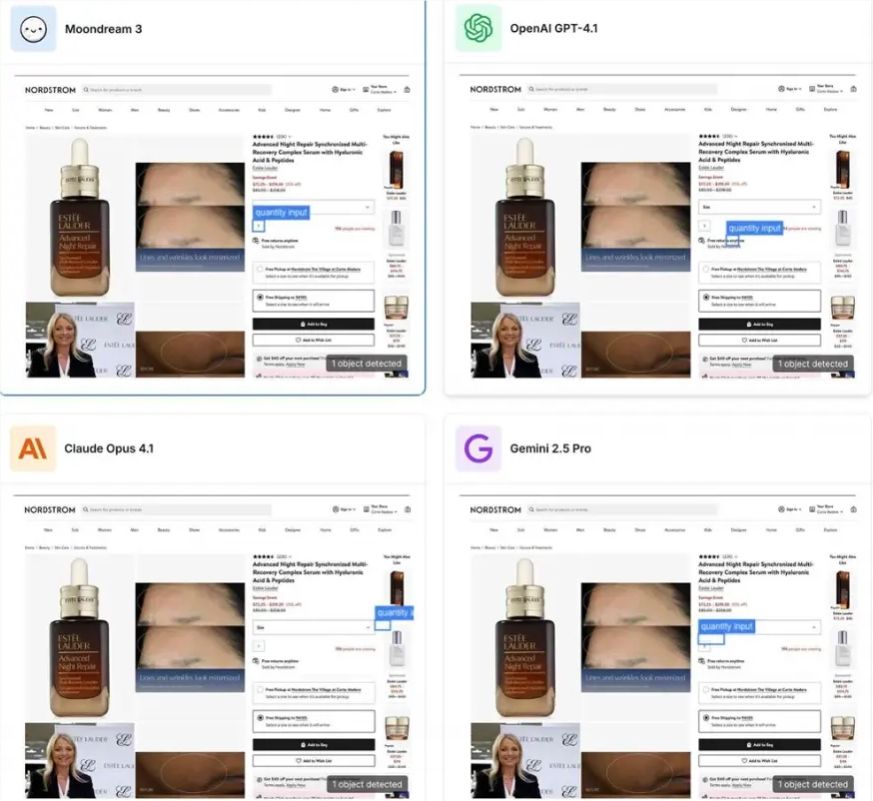

**多面视觉技能**是Moondream3.0的核心竞争力:覆盖开放词汇目标检测、点选、计数、图像描述生成、光学字符识别(OCR)等任务,还支持**结构化输出**——直接生成JSON数组提取“狗ID、毛色、项圈颜色”等信息。在用户界面理解、文档转录、目标定位等细分场景中,模型表现突出,比如能识别购物网页的数量输入框、精准转录复杂文档内容。

基准测试数据验证了性能跃升:COCO目标检测得分从30.5升至51.2(涨幅20.7);OCRBench得分从58.3提升至61.2;ScreenSpot UI F1@0.5指标达60.3。实际应用中,模型能应对复杂场景:识别穿紫色袜子的人、标记购物网页数量输入框、定位瓶子位置,甚至推荐适合pasta的餐具。其应用场景已从安全监控、无人机巡检扩展至医疗影像分析、企业级文档处理等专业领域。

作为**开源模型**,Moondream3.0践行“无需额外训练、无需真值数据、无需重型基础设施”理念,开发者通过简单提示词即可调用视觉能力。社区反馈显示,模型已成功部署于机器人语义行为系统、移动设备甚至树莓派,适配边缘计算场景——即使在资源有限的设备上,也能实现强视觉理解。

从参数效率到技能覆盖,再到开源易用性,Moondream3.0为视觉大模型的“轻量化+强能力”路径提供了新样本。对于需在边缘设备、实时场景部署视觉模型的开发者而言,这款模型或是快速落地的优选方案。