具身智能技术要让机器人精准理解人类意图并执行动作,一直以来面临多模态信息整合难、动作生成精度低等痛点。9月23日,智源机器人正式对外开源全球首个采用ViLLA(Vision-Language-Latent-Action)架构的通用具身基础大模型GO-1,旨在降低具身智能开发门槛,让更多开发者参与这一领域。

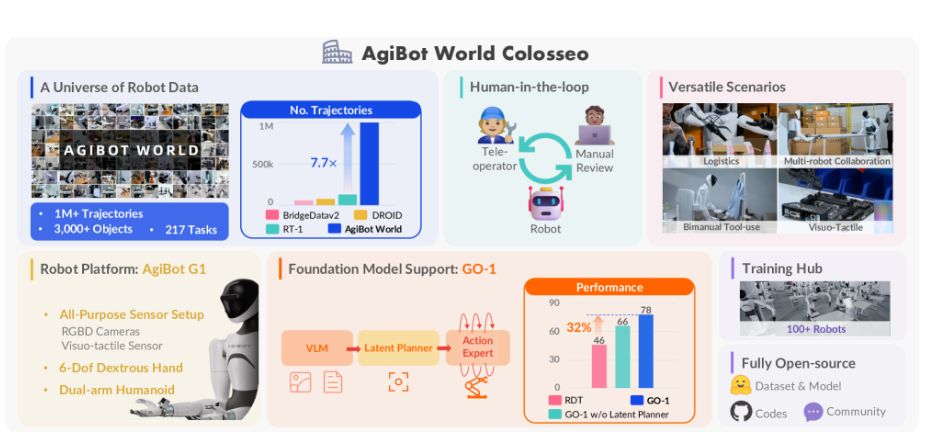

GO-1的核心是全球首创的ViLLA架构——相较于传统VLA(Vision-Language-Action)架构仅连接视觉、语言与动作,ViLLA通过引入**隐式动作令牌**这一关键设计,实现了图像、文本指令与机器人动作的更紧密关联。该架构分为三层:底层是基于InternVL-2B构建的VLM多模态理解层,支持处理视觉、力觉、语言等多源信息;中间层为Latent Planner隐式规划器,可对“整理桌面”“组装零件”等复杂任务进行高层语义理解;顶层是Action Expert动作专家模块,通过扩散模型生成连续高精度动作序列,确保机器人完成拧螺丝、抓取易碎品等精细操作。

为解决开发者“从数据到部署”的全流程需求,智源机器人同步推出Genie Studio开发平台。该平台整合了GO-1模型,提供**数据采集、模型训练、仿真验证**等全链路工具,还配套视频训练方案与统一训练框架,能将具身智能应用的开发效率提升30%以上,助力技术快速落地。

尽管GO-1以AgiBot G1机器人的真实数据为预训练基础,但已在AgiBot G1、UR5等多类机器人平台完成适配验证,同时在MuJoCo、Isaac Sim等主流仿真环境中取得优异性能——这意味着开发者无需针对特定机器人重新训练模型,极大降低了跨平台开发成本。

目前,GO-1模型已在GitHub与Hugging Face开放下载。无论是AI研究者还是具身智能初学者,都可通过以下链接获取模型,快速开启开发:

- GitHub:https://github.com/OpenDriveLab/AgiBot-World

- Hugging Face:https://huggingface.co/agibot-world/GO-1