行业痛点下的轻量化破局

当前大模型发展中,参数规模膨胀与计算成本高企成为中小企业使用AI的主要障碍——动辄百亿、千亿级参数的模型,需昂贵硬件资源支撑,让许多企业望而却步。在此背景下,百度ERNIE大模型家族的最新升级成果——ERNIE-4.5-21B-A3B-Thinking正式开源,以“轻量化参数+强推理性能”的组合,为行业提供了平衡效率与成本的新选择。

MoE架构+稀疏激活:用3B参数撬动21B性能

ERNIE-4.5-21B-A3B-Thinking的核心突破在于混合专家(MoE)架构:模型总参数规模达21B,但每处理一个token仅激活3B参数。这种稀疏激活机制大幅降低了计算开销,却保持了高水准的性能输出——尤其适合逻辑推理、数学解题、学术分析等需要深度处理长文本的任务。

值得注意的是,模型支持128K长上下文窗口,能稳定处理海量信息并生成学术级内容,显著减少“幻觉”问题;同时基于百度自研的飞桨(PaddlePaddle)深度学习框架训练优化——全球仅百度与谷歌采用自研框架训练大模型,这一设计不仅提升了多模态任务兼容性,更实现了更高效的硬件适配。

性能实测:直逼行业巨头,参数效率远超竞品

最新基准测试验证了模型的实力:在逻辑推理、数学、科学、代码、文本生成等任务中,其表现接近或超越Gemini 2.5 Pro、GPT-5等头部模型。尽管总参数仅21B(约为Qwen3-30B的70%),但在BBH、CMATH等数学推理基准上的得分已超过竞品,展现出极高的参数效率。

除基础性能外,模型还集成了高效工具调用功能,支持结构化函数调用与外部API整合,适用于程序合成、符号推理、多Agent工作流等场景;同时支持中英双语优化,覆盖全球开发者与企业的跨语言需求。

开源生态:从技术突破到普惠落地

ERNIE-4.5-21B-A3B-Thinking采用Apache 2.0许可证发布,支持商业使用,进一步降低了AI技术的应用门槛。继6月底ERNIE 4.5家族10款模型开源后,此次更新强化了百度在开源AI领域的领先地位——目前Hugging Face平台多款顶级模型均为中国开源成果,反映出中国在MoE架构与推理优化领域的全球竞争力。

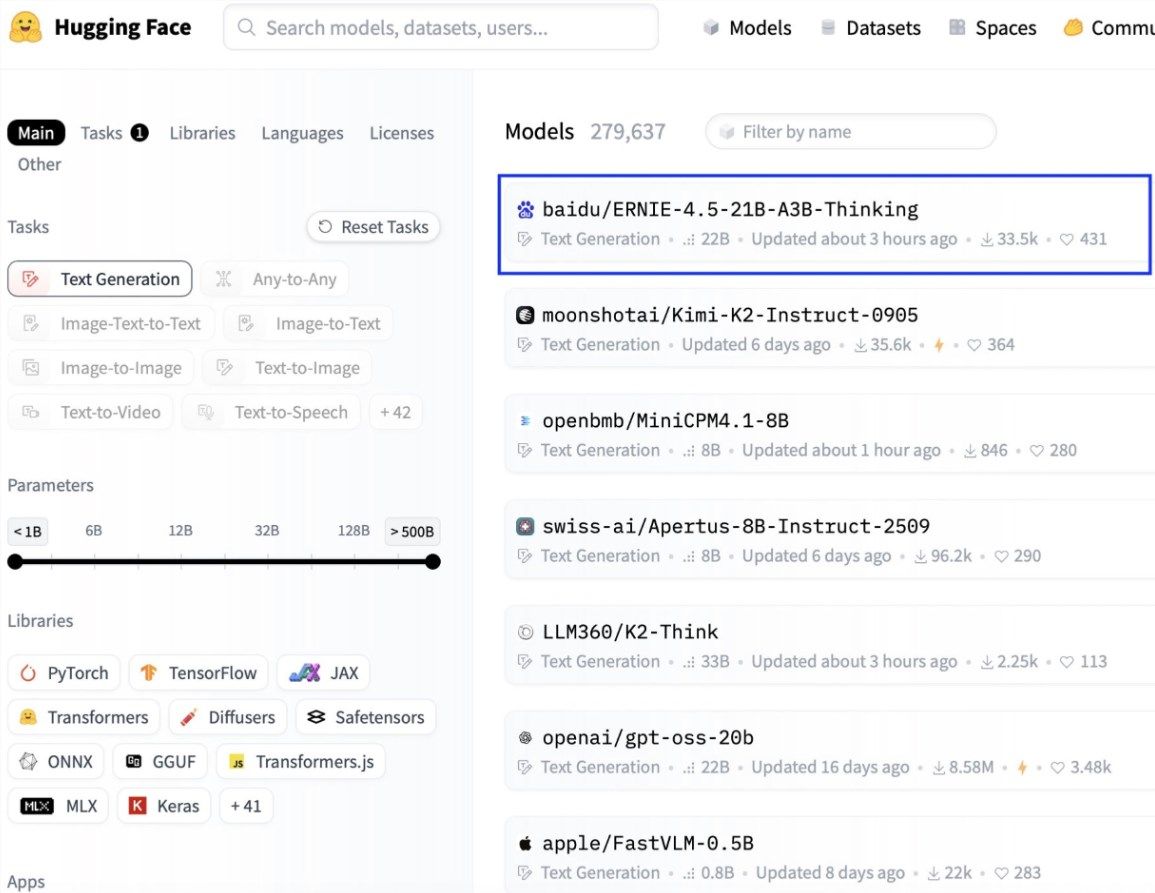

社区反馈显示,模型开源后在Hugging Face平台的下载量与趋势指数激增,开发者可通过vLLM、Transformers 4.54+、FastDeploy等工具轻松集成,实现本地部署或云端推理,成为文本生成领域的热门选择。

行业影响:推动AI从实验室走向实战

ERNIE-4.5-21B-A3B-Thinking的发布,证明了“无需万亿级稠密参数也能实现深度推理”的可能性——它为资源有限的开发者提供了高性能选项,推动AI技术从实验室走向实际应用。未来,随着飞桨框架生态的持续扩展,ERNIE系列有望在多模态、Agent产品等领域发挥更大作用,减少单一厂商垄断带来的风险。

作为ERNIE大模型的最新迭代,该模型还通过多轮强化学习优化了“思考”模式,其视觉语言(VL)变体在MathVista、MMMU等基准测试中表现出色,与OpenAI-o1的差距进一步缩小。