9月8日,苹果在Hugging Face平台集中发布FastVLM与MobileCLIP2两款多模态模型,分别主打「快」与「轻」特性,覆盖实时字幕、离线识别、相册语义搜索等日常场景,且模型、Demo及开发工具链全开放,科研与应用落地一步到位。

从用户场景到模型:解决「卡」与「重」的痛点

打开手机摄像头拍文字要等几秒才出字幕,离线时无法识别图片内容,相册搜关键词要加载半天——这些用户常遇到的「卡」与「依赖云端」问题,现在有了新解法:

- 想实时获取字幕?FastVLM能让镜头对准文字的瞬间就出结果;

- 要离线识别图片?MobileCLIP2不用上传云端,结果立刻返回;

- 想搜相册里的「黄色杯子」?MobileCLIP2的语义搜索直接定位。

FastVLM:秒级字幕的核心是「快且准」

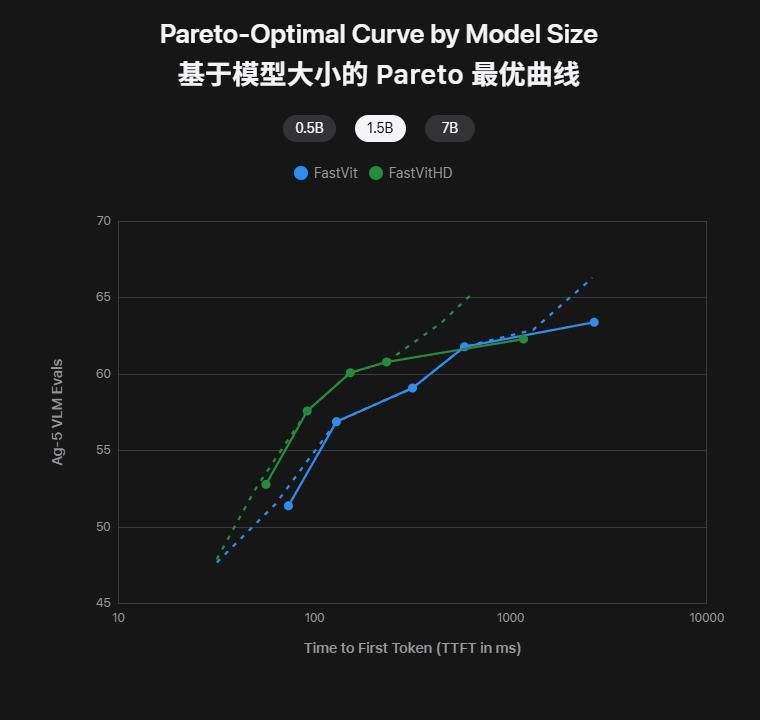

FastVLM的「快」,来自苹果自研的FastViTHD编码器。传统多模态模型处理高分辨率图像时,要么牺牲清晰度,要么被大量视觉token拖慢速度;FastViTHD通过动态缩放与混合设计,既保留高分辨率识别能力,又把首字延迟压到了竞品的1/85。

测试数据显示,FastVLM的0.5B、1.5B、7B参数量模型,在「准确率-延迟」曲线中始终处于左上角——不仅延迟远低于LLaVA-OneVision等传统模型,准确率也没落下。

用户现在就能在Hugging Face体验FastVLM的实时字幕:打开Safari授权摄像头,镜头对准文字瞬间就能出字幕——Reddit用户亲测后称「盲人用屏幕阅读器都能实时跟上」。

MobileCLIP2:轻量到能跑iPhone,精度不减

如果说FastVLM是「速度选手」,MobileCLIP2就是「轻量冠军」。作为2024年MobileCLIP的升级款,它通过多模态蒸馏、captioner teacher技术与数据增强,把模型体积压缩了一半,却保持着和SigLIP相当的精度。

过去要靠云端的图像检索、文字识别,现在MobileCLIP2能直接在iPhone上运行——照片不用上传,隐私更安全,延迟比DFN ViT-L/14低2.5倍。测试中,S4模型的参数量仅为SigLIP-SO400M/14的一半,ImageNet-1k零样本表现却不相上下。

从体验到集成:开发者能立刻走通的路线

苹果这次不仅放模型,还把「体验-开发」的路径铺好了:

- 直接体验:Hugging Face上的FastVLM Demo支持WebGPU,Safari打开就能用摄像头实时字幕;MobileCLIP2 Demo可上传照片或输入文字搜索。

- 快速集成:开发者用Core ML+Swift Transformers工具链,能把模型塞进iOS/macOS应用,调用GPU和神经引擎——既保证性能,又不费电。

技术社区反馈,这种「全开放」让开发者不用再「读论文猜实现」,而是「拿过来就能用」——比如做一个相册语义搜索应用,过去要自己调模型,现在直接集成MobileCLIP2就行。

选FastVLM还是MobileCLIP2?看场景

两款模型没有「谁更好」,只有「谁更适合」:

- 做直播字幕、视频剪辑的内容创作者→选FastVLM(秒级响应);

- 做离线翻译、相册搜索的工具类应用→选MobileCLIP2(轻量安全);

- 如果场景既要实时字幕又要相册搜索→组合用。

当然,端侧运行也有小缺点:WebGPU在部分浏览器上可能不兼容,iPhone跑模型会轻微耗电——但相比「快」和「安全」,这些都算小问题。

从「设想」到「现实」:苹果的端侧多模态路线

这次苹果在Hugging Face的「放大招」,本质是把「在手机上跑大模型」从「演示」变成了「可用」。过去开发者要解决「延迟」「体积」「精度」的矛盾,现在苹果用两款模型给出了答案:

- 要「快」,就用FastViTHD编码器解决视觉token的拖累;

- 要「轻」,就用蒸馏技术把模型压缩到手机能跑;

- 要「落地」,就把所有工具都开放给社区。

Reddit上有用户说:「以前觉得大模型离手机很远,现在打开摄像头就能用,太真实了。」这或许就是苹果这次发布的意义——让AI从「云端」走进「手心」,让用户真正摸到技术的温度。

参考资料

- 苹果Hugging Face主页:https://huggingface.co/apple

- FastVLM技术文档:https://machinelearning.apple.com/research/fast-vision-language-models

- MobileCLIP2介绍:https://ossels.ai/apple-mobileclip2-on-device-ai/