大模型训练的核心成本痛点,始终绕不开预训练阶段——以DeepSeek V3为例,其预训练成本占比超95%。过去两年,多款声称“比AdamW快1.4×-2×”的新优化器层出不穷,但实际落地率极低。近日斯坦福大学的一项研究,终于戳破了这层“加速神话”:新优化器的真实训练效率提升远低于宣称值,最高仅达1.4×,且随模型规模增大而显著减弱。

基准测试揭开“加速虚高”真相:超参数调优是关键变量

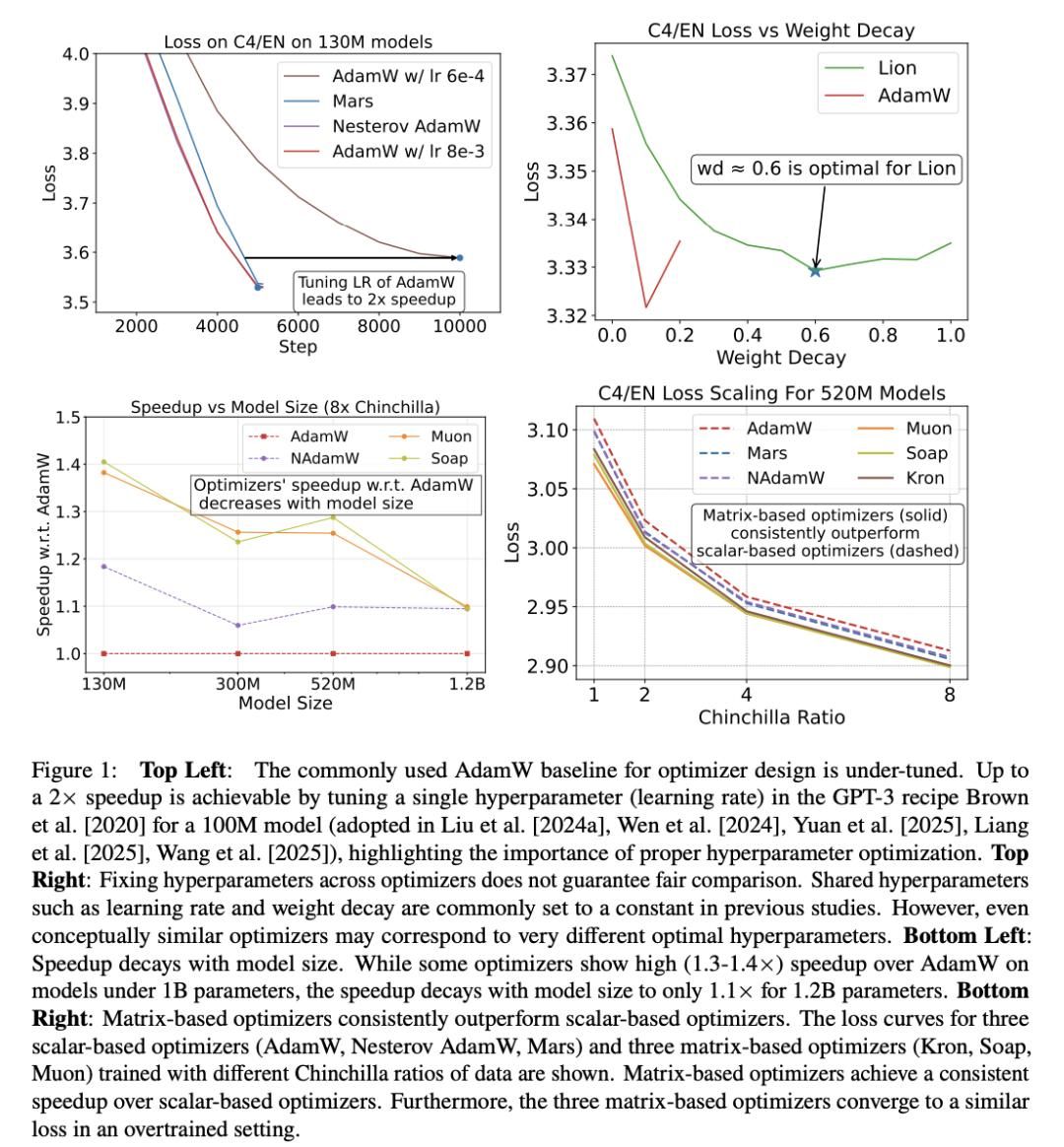

研究团队针对“新优化器为何难落地”的问题,指出两大方法学缺陷:一是基线超参数调整不当,二是实验局限于小规模模型。为验证猜想,他们设计了覆盖四种数据-模型比(1×、2×、4×、8×Chinchilla最优范式)、模型规模扩展至1.2B参数的基准测试,并重点考察超参数调优对结果的影响。

实验结果颠覆认知:新优化器的加速效果不仅低于宣称的2×,且随模型规模增大而衰减。比如Muon、Soap等新优化器在0.1B小模型上能实现1.3×加速,但在8×Chinchilla比例下的1.2B模型上,加速比骤降至1.1×;即使是表现最好的优化器,相对调优后的AdamW基线,加速也不超过1.4×。

更关键的发现是,超参数的盲目迁移会导致不公平比较——仅调整GPT-3配方中的一个超参数,就能让预训练获得2×加速,这说明“优化器本身的优势”可能被错误归因。此外,早期损失曲线的误导性也被证实:不同优化器的损失曲线在学习率衰减期会多次交叉,用中间检查点评判的结果,可能与最终训练预算下的排名完全相反。

(论文标题“神奇优化器在哪里”呼应《神奇动物在哪里》,暗含对“完美优化器”的质疑)

优化器设计三大新见解:小模型选矩阵型,超参数需“按尺度调整”

基于基准测试结果,研究团队提出三大优化器设计的关键结论:

- 小模型更适配基于矩阵的优化器:基于矩阵的优化器(如Muon、Soap)通过矩阵操作批量更新参数,在小于520M参数的模型上,持续优于基于标量的优化器(如AdamW、Lion)。后者即使调参后,平均加速比也不足1.2×;而矩阵型优化器在小模型上的加速比可达1.3×。

- 超参数需“按尺度敏感调整”:团队将超参数调优分为三阶段——细颗粒度遍历(在6种范式下找到局部最优解)、尺度敏感参数调整(聚焦跨尺度需重新调参的变量)、超参数缩放律拟合(通过非线性最小二乘预测大模型最优值)。结果显示,仅调整“尺度敏感超参数”就能将调参成本大幅降低,同时保持优化效果。

- 加速效果随数据-模型比变化:基于矩阵的优化器在数据预算增加时,加速比呈超线性上升,但随模型规模增大而下降。比如在1.2B参数模型上,所有优化器的加速比均降至1.1×左右。

(图1左上显示:仅调一个超参数,GPT-3预训练就能获得2×加速,突显超参数的重要性)

实证结论:没有“万能优化器”,AdamW仍是“基准底线”

研究团队进一步总结了三大实证结论:

- 矩阵型优化器优于标量型,但增益有限:矩阵型优化器的加速比随数据预算增加而上升,但在1.2B大模型上仅达1.1×;标量型优化器中,NAdamW、Mars等方差削减变体虽能稳定超过AdamW,但增益仅在5%以内。

- AdamW的轻量变体表现接近原版:Lion、Adam-mini等内存高效变体,尽管辅助状态更少,但其训练效率与AdamW的差距不超过5%,甚至在部分场景下更优。

- “2×加速”是误读:所有优化器均未达到过往文献声称的2×加速,最高仅1.4×——这一结果需建立在“超参数精细化调整”的基础上。

研究团队:聚焦基础模型可复现性,从理论到实证的“破局者”

该研究由斯坦福大学博士生Kaiyue Wen(清华姚班本科)主导,合作导师包括斯坦福大学计算机科学系助理教授马腾宇(清华姚班本科、普林斯顿博士),以及斯坦福大学计算机科学副教授、基础模型研究中心(CRFM)主任Percy Liang。团队长期关注深度学习的理论与实证结合,此次研究正是其“通过严格基准测试提升基础模型可理解性”理念的落地——通过开源与可复现的实验设计,为优化器研究提供了更严谨的评价标准。

研究最终强调:大模型优化器的“加速神话”,本质是方法学缺陷导致的误读。未来优化器的设计,需更注重“模型规模与数据-模型比的适配性”,而非追求“通用加速效果”。而AdamW作为“基准底线”,仍将是大模型预训练的核心选择——除非新优化器能在10B以上规模模型上,证明更稳定的效率增益。

参考资料:https://arxiv.org/abs/2509.02046