概览:OLMo框架解析

OLMo,全称为Open Language Model,是由Allen AI研究所(AI2)研发的一个开源的大型语言模型(LLM)框架。该框架的核心目标是通过对外开放研究资源,推动学术界和研究者在语言模型领域的共同探索。本文将深入探讨OLMo的官方网站信息、主要特点、模型性能及其在多个任务上的表现。

OLMo官方网站资源汇总

Allen AI研究所对OLMo项目的官方网站提供了丰富的资源链接,便于研究者和开发者深入了解和使用:

- 项目主页:Allen AI OLMo 官方网站

- 开源代码库:GitHub – Allen AI/OLMo

- Hugging Face模型库:Allen AI OLMo on Hugging Face

- 研究论文:OLMo 研究论文

OLMo的关键特性

OLMo框架具备以下显著特性:

- 庞大的预训练数据集:依托AI2的Dolma数据集,拥有3万亿个标记,为模型提供优质的学习素材。

- 多规模模型变体:提供四种不同规模的模型选项,满足多样化的研究需求。

- 详尽的资源支持:包括全面的训练文档、指标和超过500个检查点,助力研究者深入理解模型。

- 开放性和透明度:在Apache 2.0许可下公开所有代码和权重,鼓励知识共享与创新。

OLMo模型性能评估

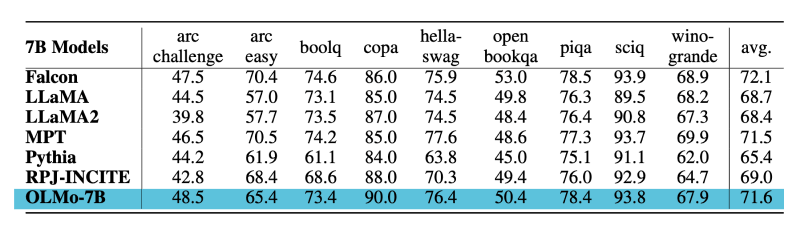

OLMo-7B模型在零样本评估中的性能表现如下:

- 下游任务零样本评估:在九个核心任务中,OLMo-7B在两个任务上取得最优成绩,在其余八个任务中均位列前三,显示出其强大的竞争力。

- 帕洛马评估框架:在多个数据源上,OLMo-7B的困惑度表现出色,尤其在与编程语言相关的数据源上显著领先于竞争对手。

- 额外任务零样本评估:在六个额外任务上,OLMo-7B保持了优于或接近其他模型的评估结果。

结论

OLMo框架以其开放性、透明度和丰富的资源为研究人员和开发者提供了强大的工具,旨在推动语言模型的研究和创新。其模型的出色性能在多个评估框架中得到了验证,确立了其在相关任务中的领导地位。

图片详解

- OLMo大模型图示:展示OLMo的架构和设计概览。

- OLMo性能对比图:详细对比了OLMo-7B与竞争对手在核心任务上的性能。

通过这些资源和信息,读者可以更直观地理解OLMo框架的核心价值和应用潜力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。